三菱総合研究所は生成AI時代の始まりに向け「生成AIラボ」を新設する。それを記念して「三菱総研 生成AIコラム」の連載をお届けする。

生成AIのリスクと懸念

前回までのコラムでは、生成AIの活用方法について紹介してきた。生成AIは、これまで人の方が得意とされていた多くの業務を代替できる可能性があり、大きな発展をもたらす革新的な技術である。企業は、紹介した5つのステップで生成AIを導入することによって、デジタル化→デジタル業務プロセス改革→デジタルビジネス変革という3段階のデジタルトランスフォーメーション(DX)が加速するだろう。

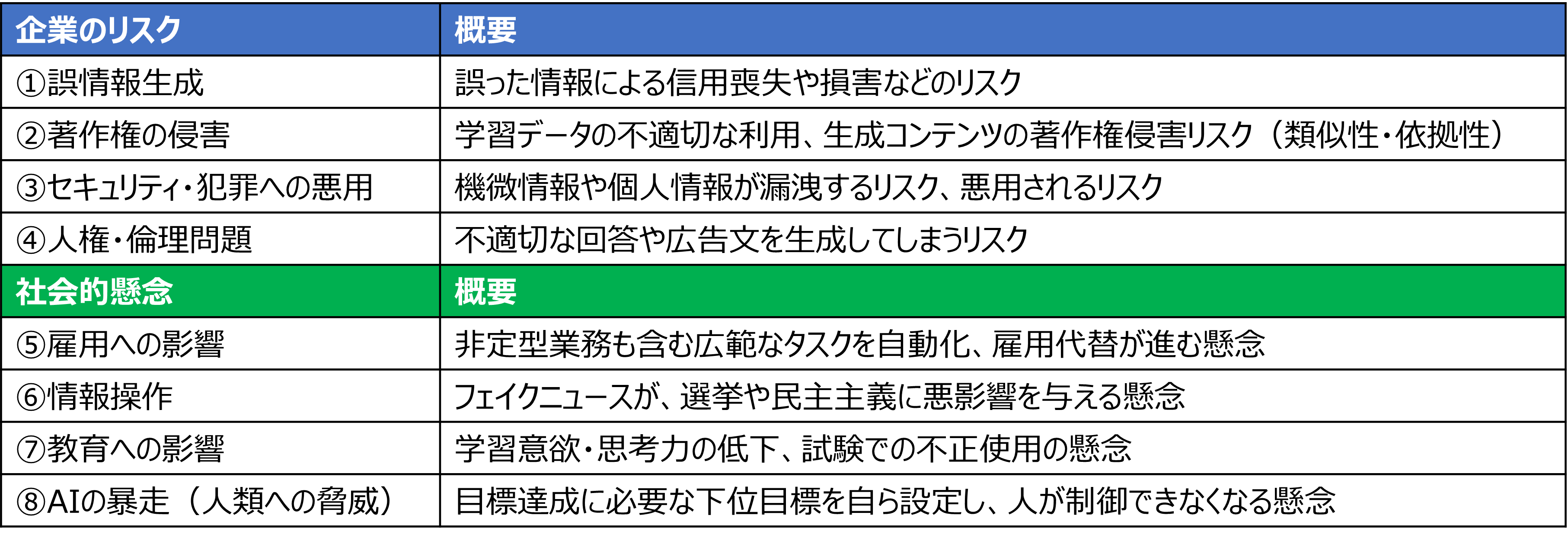

一方で、生成AIによる企業のリスクや社会的懸念が指摘されている。主なものとして、企業のリスクは、①誤情報生成、②著作権の侵害、③セキュリティ・犯罪への悪用、④人権・倫理問題の4つがある。社会的懸念は、⑤雇用への影響、⑥情報操作、⑦教育への影響、⑧AIの暴走(人類への脅威)、の4つである。

このコラムでは生成AIによる企業のリスクと対策について報告する。社会的懸念と対策については、次回のコラムで報告する。

一方で、生成AIによる企業のリスクや社会的懸念が指摘されている。主なものとして、企業のリスクは、①誤情報生成、②著作権の侵害、③セキュリティ・犯罪への悪用、④人権・倫理問題の4つがある。社会的懸念は、⑤雇用への影響、⑥情報操作、⑦教育への影響、⑧AIの暴走(人類への脅威)、の4つである。

このコラムでは生成AIによる企業のリスクと対策について報告する。社会的懸念と対策については、次回のコラムで報告する。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

なお、昨今の生成AIブームをもたらしたのは、MidjourneyやStable Diffusionなどの画像生成AI、ChatGPTなどの文章生成AIである。他にも、音声生成や動画生成など多数の生成AIが登場しているが、主に企業での利用時にメインとなる文章生成AIと画像生成AIに絞って、報告したい。

企業のリスク ①誤情報生成

企業で生成AIを利用する場合、ChatGPTなどの言語生成AIに関しては、誤情報が含まれるリスクに注意が必要だ。生成AIからは作り話が出やすく、また、この作り話に誤った情報が混じってしまっていても、とても自然な文体なので気付きにくい。

誤情報が混じってしまう原因は、2つある。1つめの原因は、生成AIの内部モデルが、コンテンツを確率的に生成する仕組みを持っていることである。AI技術の進歩でどれだけ精度が高くなっても、原理上、誤りの確率をゼロにすることはできない。2つめの原因は、AIモデルを構築する際の学習データ自体に間違いが含まれてしまう可能性である。この場合、コンテンツ生成時にその間違いを含んだまま話を作ってしまうことがありうる。

最終的には人の目でのチェックが欠かせないものの、以下のような対策を取ることで、リスクを抑えることが可能となるだろう。

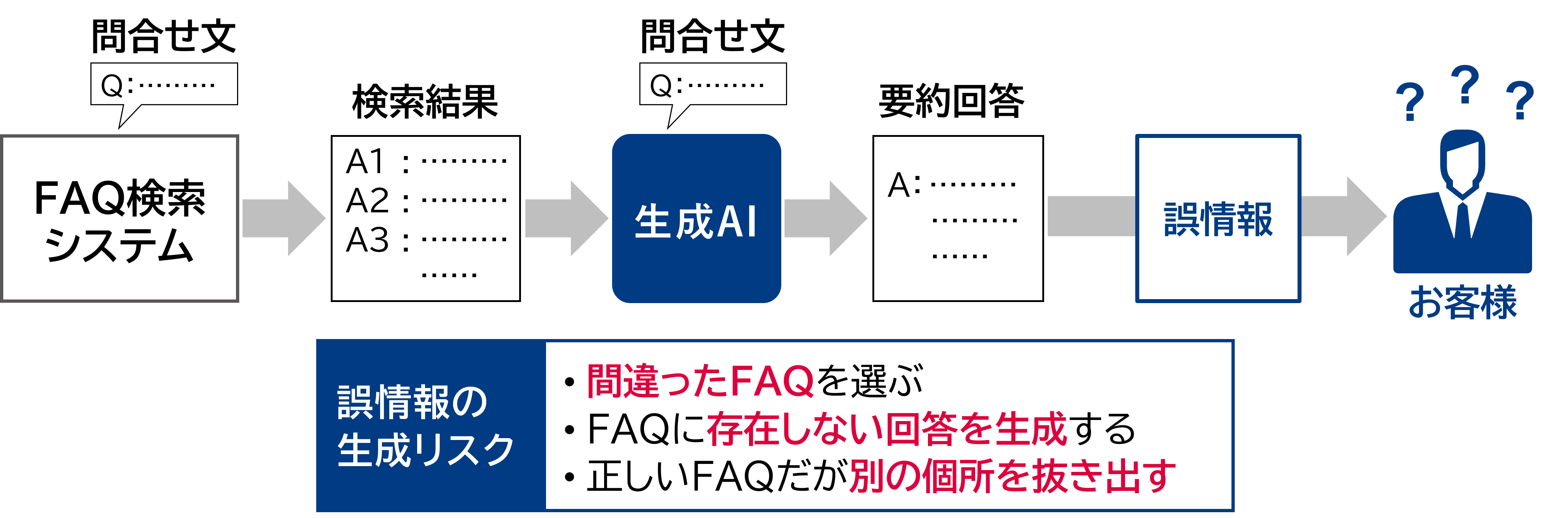

最も一般的な生成AIの利用シーンとして、受付や営業の場で質問の回答を生成し、オペレータの負荷を軽減するという使い方が考えられる。この際に、生成AIを用いて、予め内容確認済みのFAQから回答を探して要約するという使い方をすれば、誤情報のリスクはかなり低く抑えことが出来る。ただし、間違ったFAQを選んでしまう確率や、FAQの要約時に正確でない回答を生成してしまう確率も、原理上ゼロとすることはできない。当面は、生成AIによって生成された回答をそのまま使ったり、生成AIに直接回答させたりするのではなく、受付や営業を担当するオペレータを支援する情報として利用することが望ましい。

また、医療診断や法律解釈など、万が一の誤りが許されないシーンでは、特に注意が必要となる。人の判断や意思決定を支援する位置付けとして、セカンドオピニオン的な利用に留めるのが良いだろう。

誤情報が混じってしまう原因は、2つある。1つめの原因は、生成AIの内部モデルが、コンテンツを確率的に生成する仕組みを持っていることである。AI技術の進歩でどれだけ精度が高くなっても、原理上、誤りの確率をゼロにすることはできない。2つめの原因は、AIモデルを構築する際の学習データ自体に間違いが含まれてしまう可能性である。この場合、コンテンツ生成時にその間違いを含んだまま話を作ってしまうことがありうる。

最終的には人の目でのチェックが欠かせないものの、以下のような対策を取ることで、リスクを抑えることが可能となるだろう。

最も一般的な生成AIの利用シーンとして、受付や営業の場で質問の回答を生成し、オペレータの負荷を軽減するという使い方が考えられる。この際に、生成AIを用いて、予め内容確認済みのFAQから回答を探して要約するという使い方をすれば、誤情報のリスクはかなり低く抑えことが出来る。ただし、間違ったFAQを選んでしまう確率や、FAQの要約時に正確でない回答を生成してしまう確率も、原理上ゼロとすることはできない。当面は、生成AIによって生成された回答をそのまま使ったり、生成AIに直接回答させたりするのではなく、受付や営業を担当するオペレータを支援する情報として利用することが望ましい。

また、医療診断や法律解釈など、万が一の誤りが許されないシーンでは、特に注意が必要となる。人の判断や意思決定を支援する位置付けとして、セカンドオピニオン的な利用に留めるのが良いだろう。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

企業のリスク ②著作権の侵害

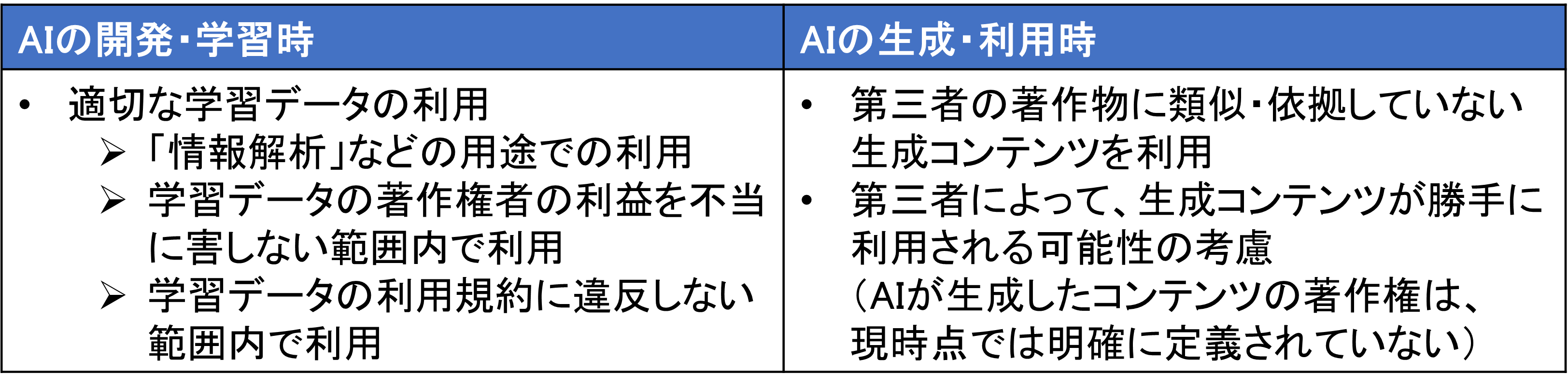

著作権の侵害のリスクは、AIの開発・学習時と生成・利用時に発生する。

技術的なハードルが高く対応できる企業は限られるものの、自社独自で生成AIを開発・学習するケースが考えられる。大量の学習データが必要となるが、日本では、著作権で保護されている記事やレポートであっても、AIが学習に利用することは基本的に認められている。ただし、著作権者の利益を不当に害しない範囲内で利用する、学習データの利用規約に違反しない、など利用条件に留意する必要がある。

生成・利用時には、AIが生成したコンテンツが第三者の著作物に類似・依拠する著作権侵害のリスクがある。著作権フリーのパブリックドメインや、自社で所有しているコンテンツ、あるいは明示的に許可を得ているデータでAIモデルを学習することが重要である。それでも、生成AIは、意図せずに第三者の著作物と類似した文章や画像を生成してしまうリスクがある。文章を対外発信する際には、生成された文章を人手で十分に修正する、文章の構成のみ生成させ、最終的に人が文章を書く、といったリスク対策をとることが望ましい。画像を対外発信する際は、特に注意が必要だ。最も手軽で安心な対策は、知財問題をクリアした学習データで訓練された画像生成AIを利用することである。例えば、自社にストックされた画像で学習されたAdobe社の画像生成サービス「Adobe Firefly」を利用すれば、著作権侵害のリスクは低くなるだろう。

更に、AIが生成したコンテンツの著作権は、現時点では明確に定義されていない。基本的に、AIが生成したコンテンツには著作権が発生しないため、第三者によって生成されたコンテンツが勝手に利用されるリスクも考慮しなければならない。

生成AIの学習データに関しては、より本質的な課題として、収益再配分と産業構造変革の議論も必要だ。現状では、AIが学習するデータの提供に対する収益再配分の仕組みが無い。例えばクリエイターは、自分のオリジナル作品をAIの学習に利用されるだけでなく、生成AIが生成した作品によって市場を席巻されるリスクがある。また、設計職や士業(司法書士・行政書士・税理士・弁理士など)は、専門知識が集約されたデータベースを生成物AIが学習することで自分たちの専門性が容易にキャッチアップされ、仕事を代替されるリスクがある。生成AI普及後を想定した産業構造改革の議論は必須である。

技術的なハードルが高く対応できる企業は限られるものの、自社独自で生成AIを開発・学習するケースが考えられる。大量の学習データが必要となるが、日本では、著作権で保護されている記事やレポートであっても、AIが学習に利用することは基本的に認められている。ただし、著作権者の利益を不当に害しない範囲内で利用する、学習データの利用規約に違反しない、など利用条件に留意する必要がある。

生成・利用時には、AIが生成したコンテンツが第三者の著作物に類似・依拠する著作権侵害のリスクがある。著作権フリーのパブリックドメインや、自社で所有しているコンテンツ、あるいは明示的に許可を得ているデータでAIモデルを学習することが重要である。それでも、生成AIは、意図せずに第三者の著作物と類似した文章や画像を生成してしまうリスクがある。文章を対外発信する際には、生成された文章を人手で十分に修正する、文章の構成のみ生成させ、最終的に人が文章を書く、といったリスク対策をとることが望ましい。画像を対外発信する際は、特に注意が必要だ。最も手軽で安心な対策は、知財問題をクリアした学習データで訓練された画像生成AIを利用することである。例えば、自社にストックされた画像で学習されたAdobe社の画像生成サービス「Adobe Firefly」を利用すれば、著作権侵害のリスクは低くなるだろう。

更に、AIが生成したコンテンツの著作権は、現時点では明確に定義されていない。基本的に、AIが生成したコンテンツには著作権が発生しないため、第三者によって生成されたコンテンツが勝手に利用されるリスクも考慮しなければならない。

生成AIの学習データに関しては、より本質的な課題として、収益再配分と産業構造変革の議論も必要だ。現状では、AIが学習するデータの提供に対する収益再配分の仕組みが無い。例えばクリエイターは、自分のオリジナル作品をAIの学習に利用されるだけでなく、生成AIが生成した作品によって市場を席巻されるリスクがある。また、設計職や士業(司法書士・行政書士・税理士・弁理士など)は、専門知識が集約されたデータベースを生成物AIが学習することで自分たちの専門性が容易にキャッチアップされ、仕事を代替されるリスクがある。生成AI普及後を想定した産業構造改革の議論は必須である。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

企業のリスク ③セキュリティ・犯罪への悪用

セキュリティ・犯罪への悪用のリスクも、幾つかのケースが考えられる。

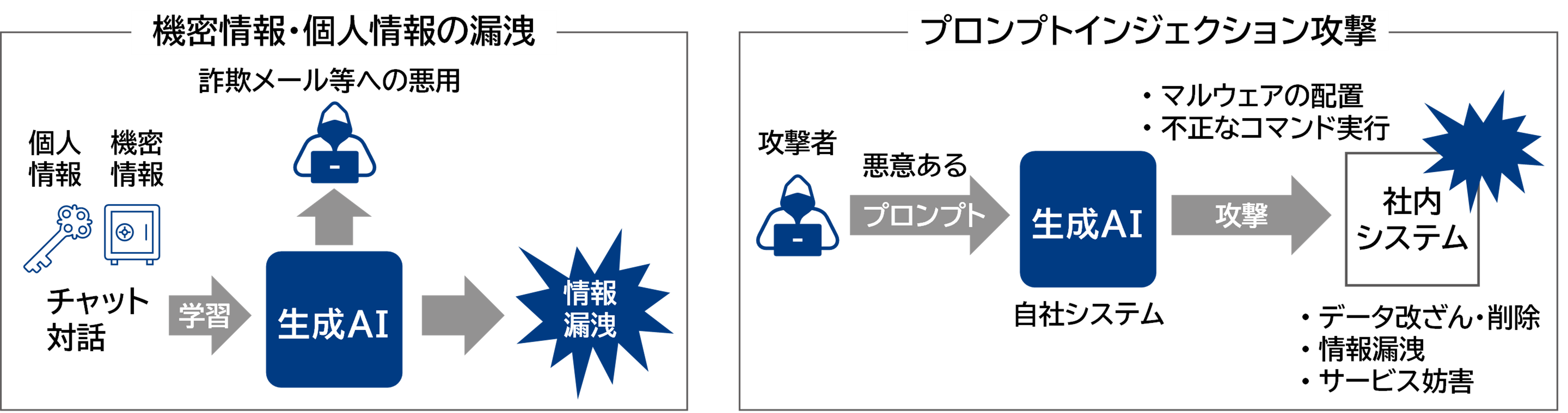

外部の生成AIを利用して社内業務を実行するケースでは、社内の機密情報をプロンプトとして入力することになる。この際に、入力した機密情報が生成AIに学習され、生成AIが社外で発話してしまうという情報漏洩のリスクが考えられる。

自社独自の生成AIを開発する場合でも、情報漏洩のリスクがある。AIモデルの学習データの中に社内の機密情報が含まれてしまうと、外部の生成AIを利用する場合と同様に、生成AIが社外で発話してしまうという情報漏洩のリスクがある。

また、金融機関では、組織間・部門間での意図していない情報共有によって、ファイアウォール規制に抵触したり、インサイダー取引を誘発したりするリスクがある。生成AIは情報を効率的に整理してくれる一方で、他部署の情報を含んだ整理になってしまう可能性がある。生成AIが情報源にアクセスする際の適切なアクセス権限設定や、生成コンテンツのフィルタリング等の技術的対応が必要となる。

更に、生成AIが悪用されるリスクも考慮しなければならない。例えば、悪用を考えている者が自社の生成AIとの対話を通じて、機密情報を引き抜く情報漏洩リスクが考えられる。これは、「敵対的攻撃」や「プロンプトインジェクション」と呼ばれるもので、不正な取引を承認させるような悪用も考えられる。生成AIは悪く言えばお人好しで、制約が無ければ何でも答えようとしてしまう。本人確認を要する場面で、他人になりすますために生成AIが悪用されるリスクも考慮しなければならない。生成AIを十分に活用するには、各企業で、上記リスクに対応可能なデータ管理とリスク管理の仕組みが求められる。

外部の生成AIを利用して社内業務を実行するケースでは、社内の機密情報をプロンプトとして入力することになる。この際に、入力した機密情報が生成AIに学習され、生成AIが社外で発話してしまうという情報漏洩のリスクが考えられる。

自社独自の生成AIを開発する場合でも、情報漏洩のリスクがある。AIモデルの学習データの中に社内の機密情報が含まれてしまうと、外部の生成AIを利用する場合と同様に、生成AIが社外で発話してしまうという情報漏洩のリスクがある。

また、金融機関では、組織間・部門間での意図していない情報共有によって、ファイアウォール規制に抵触したり、インサイダー取引を誘発したりするリスクがある。生成AIは情報を効率的に整理してくれる一方で、他部署の情報を含んだ整理になってしまう可能性がある。生成AIが情報源にアクセスする際の適切なアクセス権限設定や、生成コンテンツのフィルタリング等の技術的対応が必要となる。

更に、生成AIが悪用されるリスクも考慮しなければならない。例えば、悪用を考えている者が自社の生成AIとの対話を通じて、機密情報を引き抜く情報漏洩リスクが考えられる。これは、「敵対的攻撃」や「プロンプトインジェクション」と呼ばれるもので、不正な取引を承認させるような悪用も考えられる。生成AIは悪く言えばお人好しで、制約が無ければ何でも答えようとしてしまう。本人確認を要する場面で、他人になりすますために生成AIが悪用されるリスクも考慮しなければならない。生成AIを十分に活用するには、各企業で、上記リスクに対応可能なデータ管理とリスク管理の仕組みが求められる。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

企業のリスク ④人権・倫理問題

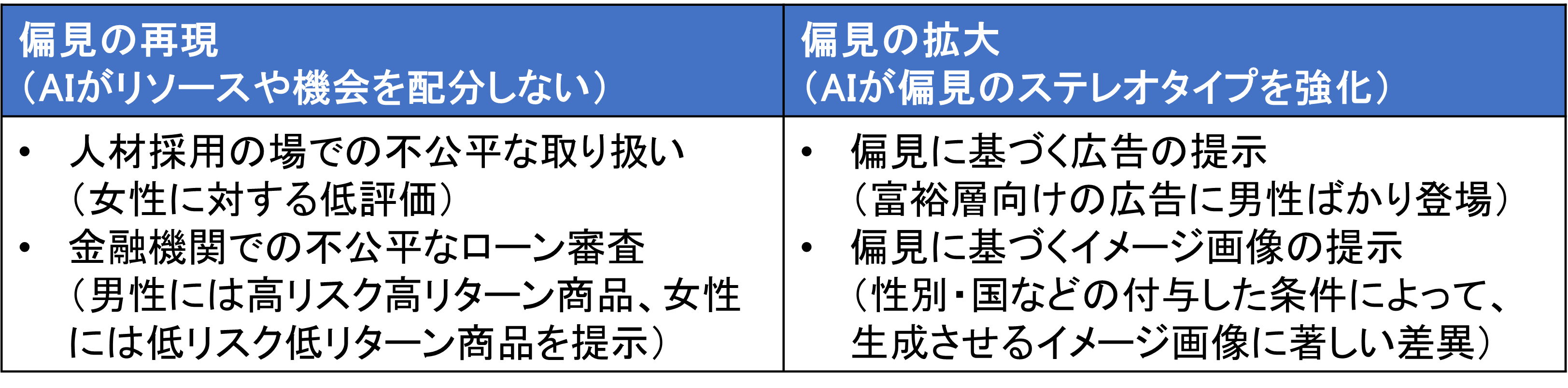

生成AIによって生成されるアウトプットには、特定のグループに対して不公平な取り扱いをするなど、AIが差別・偏見を助長する人権・倫理上のリスクがある。このタイプのリスクには、AIがリソースや機会を配分しない「偏見の再現」と、AIが偏見のステレオタイプを強化しまう「偏見の拡大」の2種がある。

「偏見の再現」に該当するリスクの具体例として、人材採用やサービス提示の場での不公平な取り扱いが挙げられる。例えば、金融機関において、ポートフォリオ構成によらず男性には高リスク高リターン商品、女性には低リスク低リターン商品を勧めるAIは、性差別を有する不公平とみなされる。

「偏見の拡大」に該当するリスクの具体例として、偏見に基づく広告の提示が挙げられる。例えば、富裕層向けの広告に生成AIが男性ばかり登場させることは、AIによる偏見の拡大とみなされる。

これらのリスクへの対策として、どれほど偏見をもっているかを測る指標も提案されている。指標を用いた定期的なチェックが、対策の一つとして有効だろう。

AIの性能向上に伴う大規模化によって、AIの内部構造を人が理解できなくなってしまうブラックボックス化の流れを止めることは難しい。内部動作に関する透明性が欠如してしまうことで、規制当局に対する説明責任を果たしづらいという課題もある。大事なことは、生成AIによって生成されたコンテンツを、最終的に人がチェックするという原則の徹底である。チャットボットのように自動的に文章生成する場合には、十分なテストやNGワードチェックなどを併用することも対策となる。AIの透明性は、金融や法律、医療に限らず、各国で盛んに議論されているAI規制の中核となる必須事項である。AIモデルの透明性を高めて説明責任を果たすことは、今後ますます重要になるだろう。

AIの偏見の問題は、人間社会の価値観がAIに反映されてしまっているという側面でもある。AIの技術的な対策とともに、実社会で偏見をなくしていく取り組みが本質的に重要であることは、言うまでもない。

「偏見の再現」に該当するリスクの具体例として、人材採用やサービス提示の場での不公平な取り扱いが挙げられる。例えば、金融機関において、ポートフォリオ構成によらず男性には高リスク高リターン商品、女性には低リスク低リターン商品を勧めるAIは、性差別を有する不公平とみなされる。

「偏見の拡大」に該当するリスクの具体例として、偏見に基づく広告の提示が挙げられる。例えば、富裕層向けの広告に生成AIが男性ばかり登場させることは、AIによる偏見の拡大とみなされる。

これらのリスクへの対策として、どれほど偏見をもっているかを測る指標も提案されている。指標を用いた定期的なチェックが、対策の一つとして有効だろう。

AIの性能向上に伴う大規模化によって、AIの内部構造を人が理解できなくなってしまうブラックボックス化の流れを止めることは難しい。内部動作に関する透明性が欠如してしまうことで、規制当局に対する説明責任を果たしづらいという課題もある。大事なことは、生成AIによって生成されたコンテンツを、最終的に人がチェックするという原則の徹底である。チャットボットのように自動的に文章生成する場合には、十分なテストやNGワードチェックなどを併用することも対策となる。AIの透明性は、金融や法律、医療に限らず、各国で盛んに議論されているAI規制の中核となる必須事項である。AIモデルの透明性を高めて説明責任を果たすことは、今後ますます重要になるだろう。

AIの偏見の問題は、人間社会の価値観がAIに反映されてしまっているという側面でもある。AIの技術的な対策とともに、実社会で偏見をなくしていく取り組みが本質的に重要であることは、言うまでもない。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

リスクをチャンスに

これまで見てきたような生成AIのリスクは、企業にとって単なるコスト要因に過ぎないものだろうか。決してそのようなことは無く、リスクをビジネスチャンスととらえ、新しいサービス提供に乗り出している企業もある。

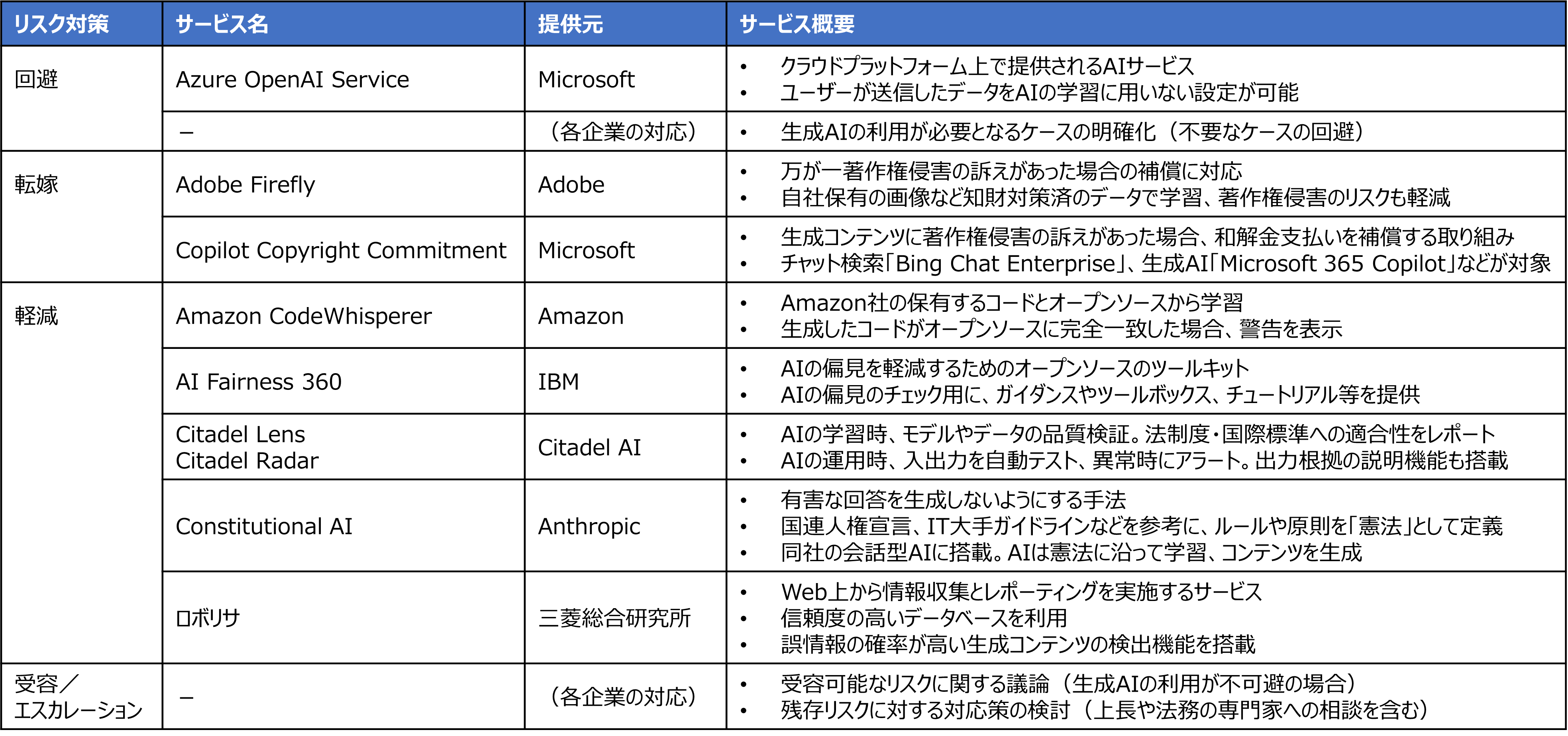

脅威となるリスクへの対策として、例えば、プロジェクトマネジメントの手法を体系的に整理したPMBOKでは以下5つを挙げている。

脅威となるリスクへの対策として、例えば、プロジェクトマネジメントの手法を体系的に整理したPMBOKでは以下5つを挙げている。

- ・回避:リスクを無くして排除

- ・転嫁:リスクを第三者に移転

- ・軽減:リスクを受容可能なレベルまで低減

- ・受容:リスクが顕在化した時点で対処

- ・エスカレーション:権限を超える影響を上長等に報告

これらの対策に対応する形で、生成AIのリスクに対するサービスが出始めている。

リスクの回避

まず「回避」に関して、例えばMicrosoft社のAzure OpenAIサービスは、ユーザーが送信したデータを学習に利用しない設定となっている。少なくとも、ユーザーが入力したデータに関しては、生成AIから機密情報が漏えいしてしまうリスクを回避することができる。並行して、生成AIを利用しようとしている企業は、そもそもなぜ生成AIを利用するのか、生成AIを利用しなければならない状況なのか、を明確にする必要がある。もし生成AIの他に選択肢があるならば、あえて生成AIによるリスクを負う必要がなくなり、リスクを回避することができる。生成AIの利用が必要なケースの整理が重要だ。

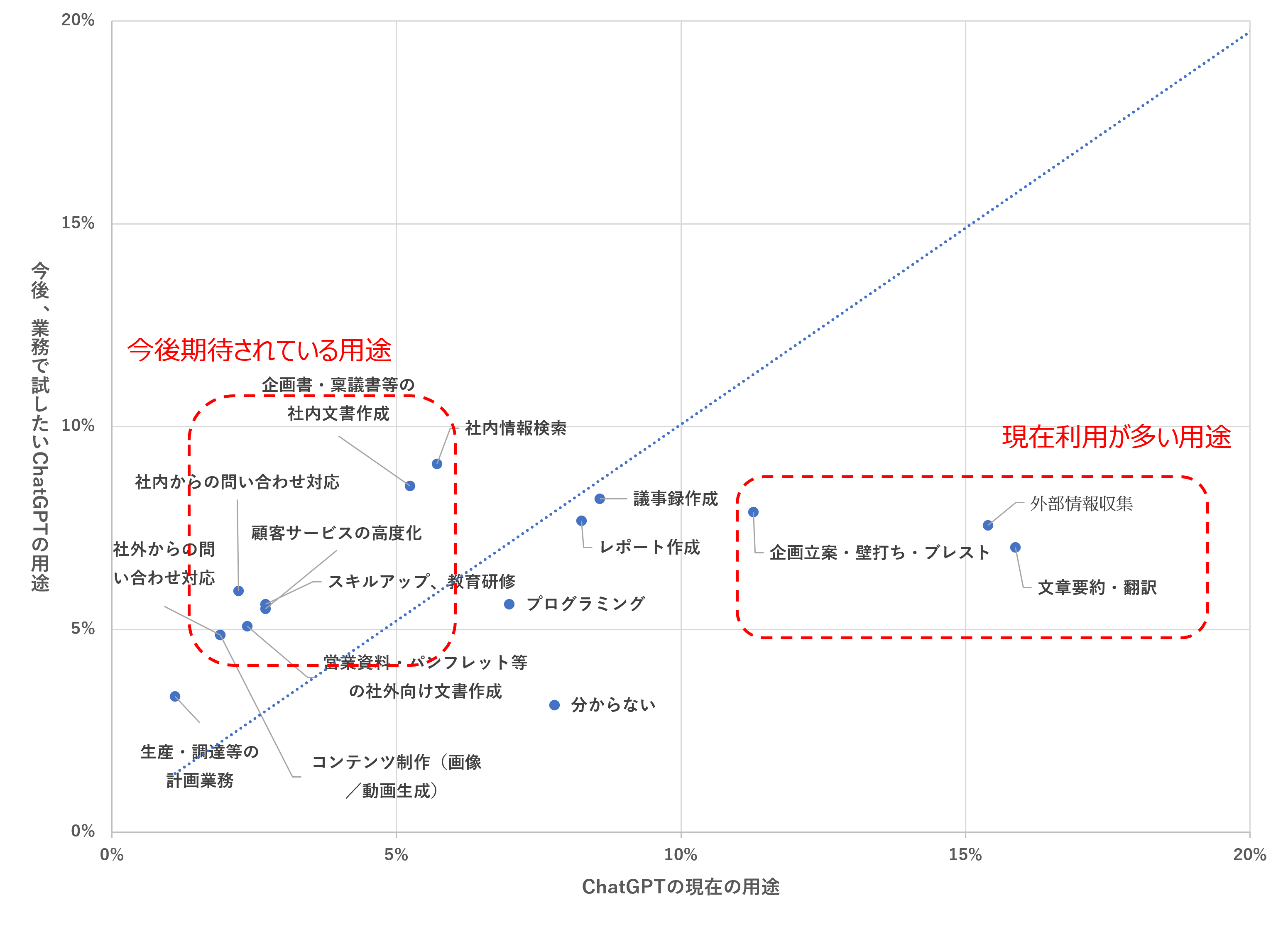

一方で、企業にとっては、リスクを完全に回避するため生成AIをまったく利用しないということは、現実的でないだろう。当社が実施したChatGPTに関するアンケート調査」(三菱総合研究所セミナー参加233社対象、2023年10月実施)によると、現在は外部情報収集、文章要約・翻訳、企画提案・壁打ち・ブレスト等での活用が多く、今後は社内情報検索、社内文書作成、顧客サービスの高度化などでの活用が期待されている。

一方で、企業にとっては、リスクを完全に回避するため生成AIをまったく利用しないということは、現実的でないだろう。当社が実施したChatGPTに関するアンケート調査」(三菱総合研究所セミナー参加233社対象、2023年10月実施)によると、現在は外部情報収集、文章要約・翻訳、企画提案・壁打ち・ブレスト等での活用が多く、今後は社内情報検索、社内文書作成、顧客サービスの高度化などでの活用が期待されている。

三菱総合研究所調査

出所:株式会社 三菱総合研究所

三菱総合研究所調査

出所:株式会社 三菱総合研究所

リスクの転嫁

リスク対策の次の選択肢は、生成AIを利用することによって生じるリスクの「転嫁」だ。リスクの転嫁に相当するサービスの事例として、先述のAdobe社の画像生成AI「Firefly」がある。この画像生成AIは、著作権に問題のないAdobe社保有の画像で学習しており、著作権侵害のリスクが低いだけでなく、万が一著作権侵害の訴えがあった場合の補償にも対応するサービスを展開している。同様に、文章生成などの機能を持つMicrosoft社の生成AI「Microsoft 365 Copilot」でも、著作権侵害の訴えに対して和解金支払を補償する「Copilot Copyright Commitment」サービスを提供している。生成AIの利用を検討している企業にとって、このようにリスクを第三者へ転嫁できるサービスは非常に有り難いものである。

リスクの軽減

転嫁が難しいリスクについては、リスクの「軽減」による対策が有効となる。生成AIの原理上、出力に対する正確性を100%補償することは困難であるが、このリスクをビジネスチャンスととらえ、リスクを軽減させるサービスが登場している。例えば、Amazon社のコード生成AI「Code Whisperer」は、Amazon社が保有するコードとオープンソースのコードから学習しており、オープンソースに一致した際に警告を表示させるというものだ。開発者にとって、少しでも著作権侵害のリスクを軽減することは、作業効率性の観点からも非常に有益だろう。また、三菱総合研究所のWeb情報収集・レポーティングを行う生成AIサービス「ロボリサ®」は、信頼度の高いデータベースから情報収集を行い、誤情報の可能性が高い箇所を検知する独自機能が実装されている。人が重点的にチェックすべき箇所の参考情報を示してくれるものであり、作業負荷も軽減する。

リスクの受容/エスカレーション

リスクの回避、転嫁、軽減を経ても、生成AIによるリスクがゼロになるということは無い。最終的に残存したリスクは「受容」あるいは「エスカレーション」することになる。例えば、上述の著作権侵害のリスクを転嫁するサービスに関しても、訴訟の金銭的補償は得られるものの、企業のレピュテーションリスクを避けることはできない。企業として「受容」できるレベルのリスクなのか、上長への「エスカレーション」も含めて検討する必要がある。場合によっては、残存リスクに対して更なる対応策がないか、法務の専門家も交えて検討するのが良いだろう。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

自社の活用段階に合わせたルール整備のもとでDXを加速

冒頭に述べたように、生成AIのような革命的な技術は、DXを大いに加速させるだろう。まずは使ってみるという姿勢が大切だ。そのためにも、各企業は自社で実施しているリスク対策に応じて、ルール整備とガバナンスの取り組みを進める必要がある。

既に企業では、生成AIで新たに発生するリスクに対応させ、対策を強化する動きが見られる。当社が実施したChatGPTに関するアンケート調査」(三菱総合研究所セミナー参加233社対象、2023年10月実施)では、半数の企業がChatGPTの利用ルールを整備済と回答、整備中の企業も含めると75%に達している。

既に企業では、生成AIで新たに発生するリスクに対応させ、対策を強化する動きが見られる。当社が実施したChatGPTに関するアンケート調査」(三菱総合研究所セミナー参加233社対象、2023年10月実施)では、半数の企業がChatGPTの利用ルールを整備済と回答、整備中の企業も含めると75%に達している。

三菱総合研究所調査

出所:株式会社 三菱総合研究所

三菱総合研究所調査

出所:株式会社 三菱総合研究所

生成AIの技術進展は日進月歩である。このコラムで紹介したようなリスクに対応する新たなサービスも展開されており、今後も益々増えていくだろう。各企業は、新たなサービスが自社に導入できるか常に情報収集を進め、自社の活用段階に合わせたルール整備とガバナンスの取り組みを随時更新していくことが求められる。憂いなく生成AIを利用できる体制のもとでのDX加速に期待したい。

-

三菱総合研究所 生成AIコラム

https://dx.mri.co.jp/generative-ai/column/ -

内閣府の「AI時代の知的財産権検討会」で議論が進められている。

https://www.kantei.go.jp/jp/singi/titeki2/ai_kentoukai/kaisai/index.html - ただし、不正使用や有害コンテンツ生成の防止のため、入力されたプロンプトと生成されたコンテンツを30日間保存する対策が取られている。不正が自動検出されると、Microsoft社のレビュー担当者が内容を確認する。この機能はオフにすることも可能だが、金融や法律、医療等の規制業界では、機密情報を預ける時点で、機密保護ルールと不整合を起こす可能性があり、留意が必要である。

-

株式会社三菱総合研究所 ニュースリリース 2023.10.30 WebサーベイAI「ロボリサ」のレポート作成機能が進化 自然な表現でさらに高品質なレポートを自動作成

https://www.mri.co.jp/news/press/20231030.html