三菱総合研究所は生成AI時代の始まりに向け「生成AIラボ」を新設する。それを記念して「三菱総研 生成AIコラム」の連載をお届けする。

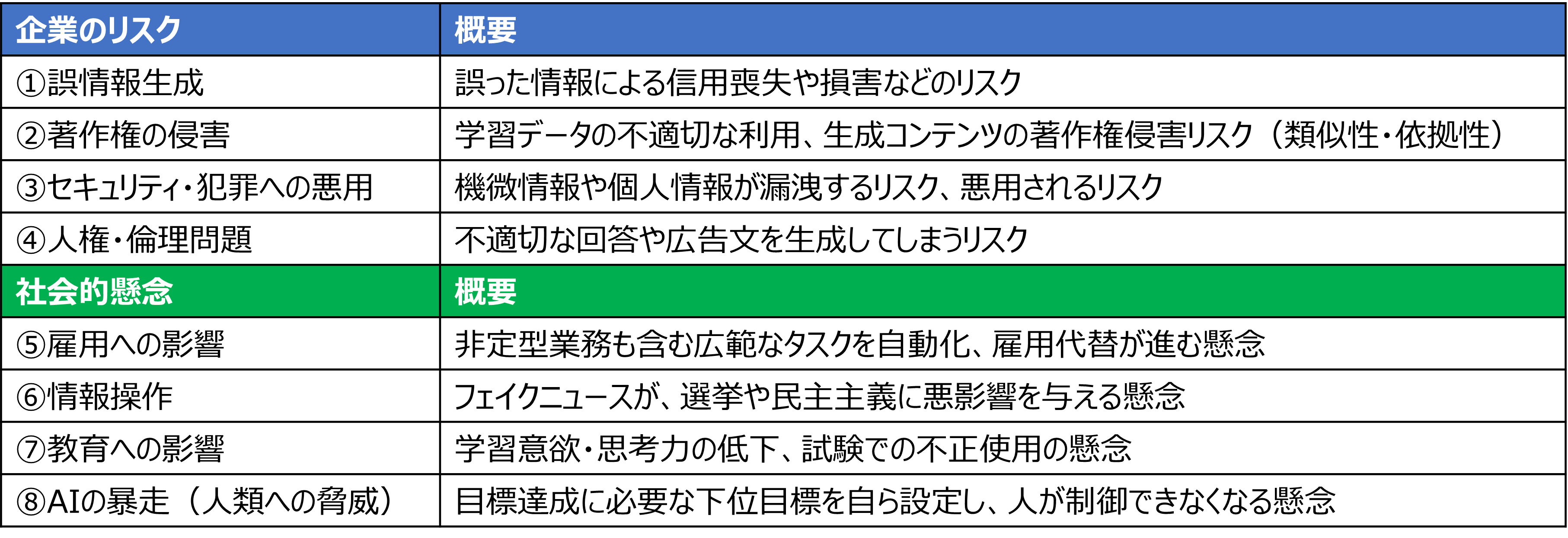

前回のコラムでは、生成AIは大きな発展をもたらす革新技術である一方で、企業のリスクや社会的懸念があることを紹介した。また、リスクを単なるコストではなくビジネスチャンスととらえた新たなサービスが登場していることなどを紹介した。生成AIは登場したばかりの技術であり、未知のリスクが顕在化する可能性も高い。新たなサービスはこれからも増え続けるだろう。

各企業は、新たなサービスが自社に導入できるか情報収集しつつ、自社の活用段階に合わせたルール整備とガバナンスのもとで生成AIを利用することによって、DXを加速させたい。

今回のコラムでは、生成AIによる4つの社会的懸念に関して、どのようなことが懸念されているか、どのような対策が考えられているか、を紹介する。

各企業は、新たなサービスが自社に導入できるか情報収集しつつ、自社の活用段階に合わせたルール整備とガバナンスのもとで生成AIを利用することによって、DXを加速させたい。

今回のコラムでは、生成AIによる4つの社会的懸念に関して、どのようなことが懸念されているか、どのような対策が考えられているか、を紹介する。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

生成AIによる社会的懸念 ⑤雇用への影響

生成AIによる社会的懸念として、雇用への甚大な影響を予測する報告が続いている。なぜ、雇用への影響が懸念されているのだろうか。

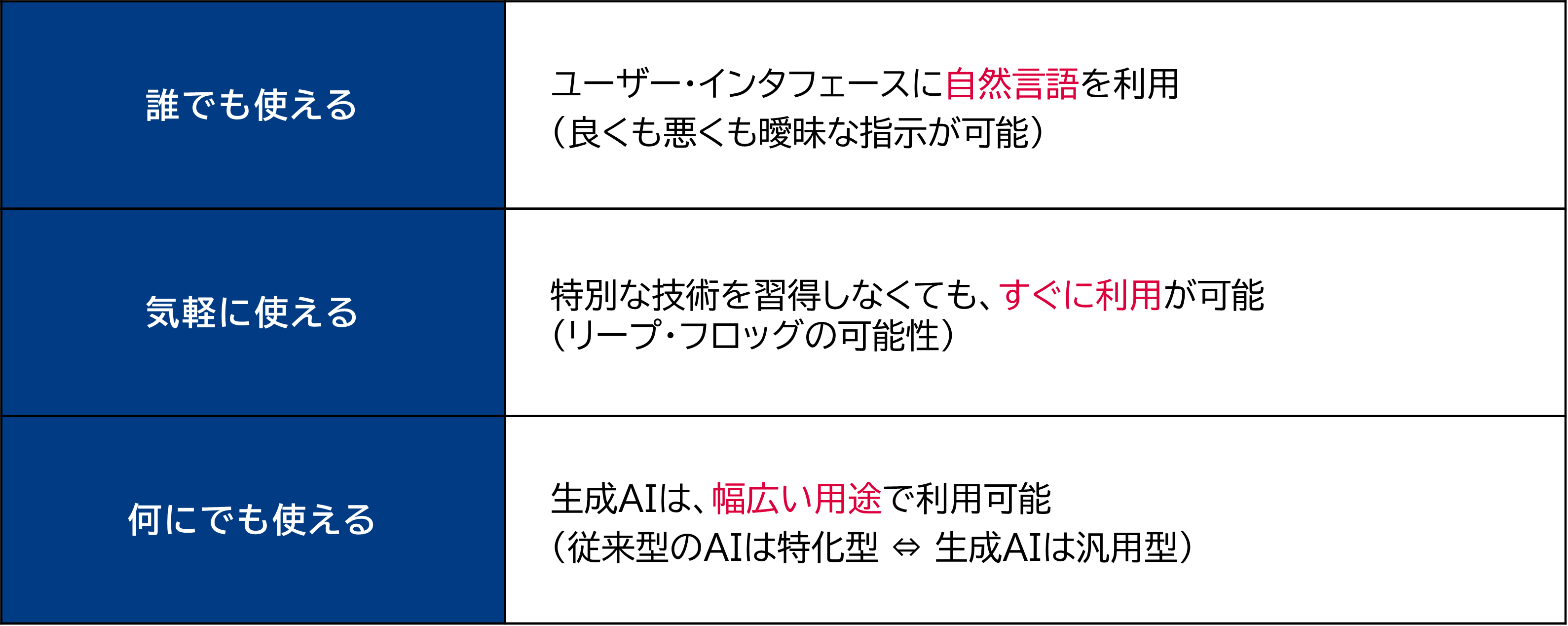

生成AIは、「誰でも使える」「気軽に使える」「何にでも使える」という3つの技術的特徴によって、爆発的に利用が増えている。

ChatGPTの核となる技術は、数年前から存在していた。ChatGPTがこれだけ注目されるようになったのは、ユーザーインターフェースとして自然言語が利用できること、特に日本語で利用できることが大きい。

これまでのAIは、プログラミング技術をもったプログラマーしか使いこなせないものでもあった。生成AIは、このような特別な技術を持たない利用者もすぐに利用することができる。

更に、生成AIは、幅広い用途で利用可能ということが挙げられる。従来のAIは特化型で特定のタスクのみが得意であり、用途は限定されていた。生成AIは汎用型のAIで様々なタスクが得意なため、幅広い用途で利用可能という違いがある。

指示が簡単で色々な用途に対応してくれるのであれば、AIに仕事をお願いしない訳がない。これまで人間の方が得意とされていた非定型業務でも、労働代替が加速するだろう。

生成AIは、「誰でも使える」「気軽に使える」「何にでも使える」という3つの技術的特徴によって、爆発的に利用が増えている。

ChatGPTの核となる技術は、数年前から存在していた。ChatGPTがこれだけ注目されるようになったのは、ユーザーインターフェースとして自然言語が利用できること、特に日本語で利用できることが大きい。

これまでのAIは、プログラミング技術をもったプログラマーしか使いこなせないものでもあった。生成AIは、このような特別な技術を持たない利用者もすぐに利用することができる。

更に、生成AIは、幅広い用途で利用可能ということが挙げられる。従来のAIは特化型で特定のタスクのみが得意であり、用途は限定されていた。生成AIは汎用型のAIで様々なタスクが得意なため、幅広い用途で利用可能という違いがある。

指示が簡単で色々な用途に対応してくれるのであれば、AIに仕事をお願いしない訳がない。これまで人間の方が得意とされていた非定型業務でも、労働代替が加速するだろう。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

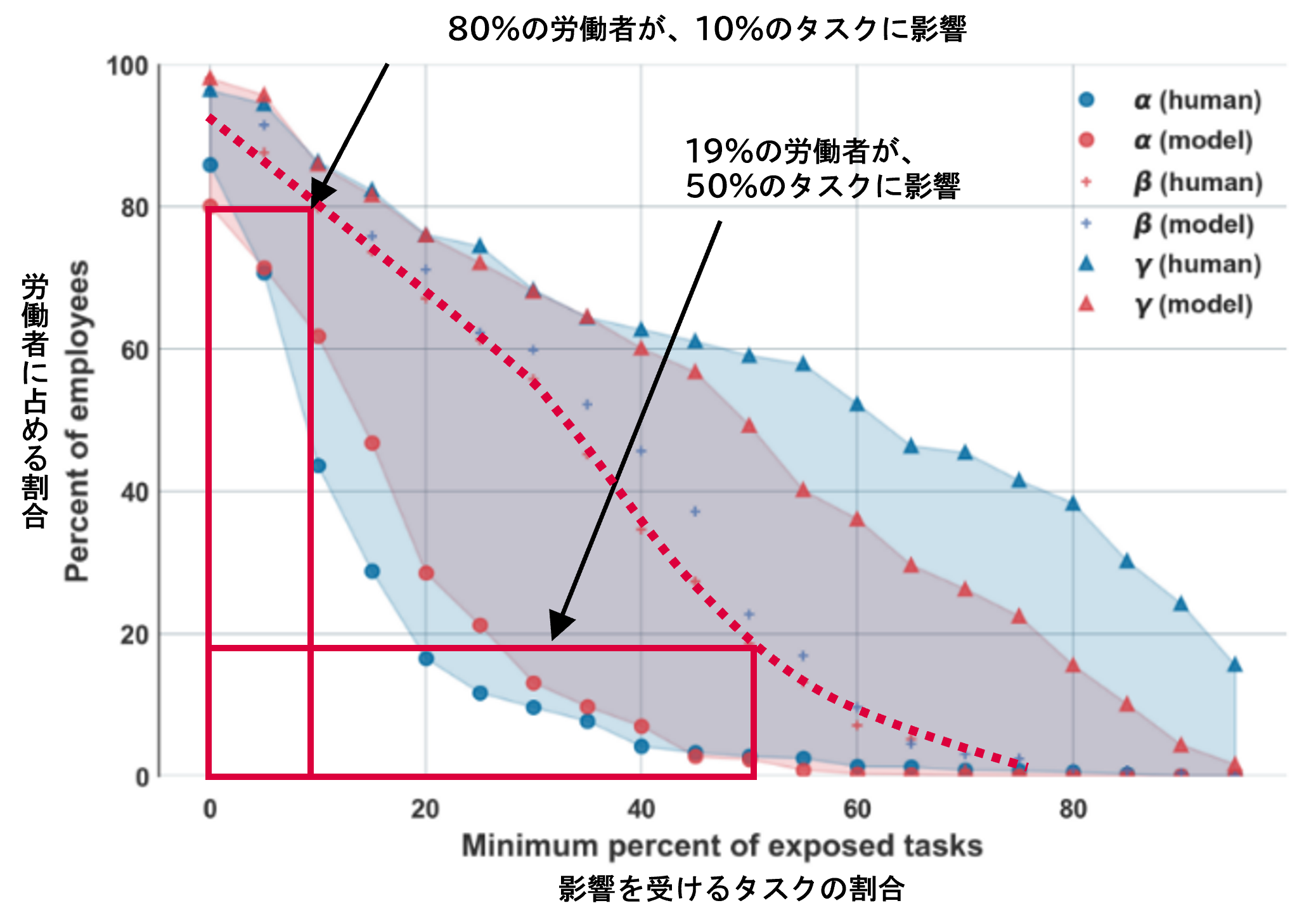

ChatGPTの開発元であるOpenAIからは、生成AIによって「80%の労働者が10%のタスク」「19%の労働者が50%のタスク」で影響を受けるとの分析結果がある。当社でも、生成AIによる雇用への影響は460万人、従来型のAIも加えると970万人に影響があると試算している。日本の全就業人口の15%強にあたり、看過できない規模の影響だ。

出所:OpenAI, “GPTs are GPTs: An Early Look at the Labor Market Impact Potential of Large Language Models”

出所:OpenAI, “GPTs are GPTs: An Early Look at the Labor Market Impact Potential of Large Language Models” https://arxiv.org/abs/2303.10130 (閲覧日2023年12月21日)より三菱総合研究所が注釈を追記

それでは、雇用への影響の懸念に対して、どのような対策が有効であろうか。

短期的な対策として、甚大な影響を受ける雇用者への保証が必要だ。

ハリウッドの脚本家や俳優らが結成した労働組合は、生成AIによって労働が代替されないような対策を求めてストライキを実施、待遇改善やAIの利用制限などで制作会社側と合意に達している。生成AIの技術が進化して利用も進むにつれ、影響を受ける職業は更に増えるだろう。過渡的な状況にある労働者の生活保障、職業によって得られる生きがいの尊重は、社会として最低限の責務である。

中長期的には、リスキリング環境の整備や、雇用環境の充実が挙げられるだろう。

労働代替によって生じる需給ギャップ解消に向けたリスキリング環境の重要性は、以前から指摘されていた。生成AIによって課題が顕在化したともいえる。リスキリング環境の整備と並行して、スキルと人材をマッチングさせるようなサービスも必要になるため、社会課題の解決にとどまらずビジネスチャンスにもなりうる。

一方で、職業によって、あるいは、労働者が現在置かれている環境によっては、リスキリング自体が難しいケースもあるだろう。新たなスキルを学ぶためには、継続的な学習とリスキリングが可能な機会の提供、AIに代替されにくい課題解決や発見といったスキルが求められる人材の育成、など組織としてのバックアップも求められる。労働者が安心してリスキリングに取り組めるような就業環境の充実が重要である。

短期的な対策として、甚大な影響を受ける雇用者への保証が必要だ。

ハリウッドの脚本家や俳優らが結成した労働組合は、生成AIによって労働が代替されないような対策を求めてストライキを実施、待遇改善やAIの利用制限などで制作会社側と合意に達している。生成AIの技術が進化して利用も進むにつれ、影響を受ける職業は更に増えるだろう。過渡的な状況にある労働者の生活保障、職業によって得られる生きがいの尊重は、社会として最低限の責務である。

中長期的には、リスキリング環境の整備や、雇用環境の充実が挙げられるだろう。

労働代替によって生じる需給ギャップ解消に向けたリスキリング環境の重要性は、以前から指摘されていた。生成AIによって課題が顕在化したともいえる。リスキリング環境の整備と並行して、スキルと人材をマッチングさせるようなサービスも必要になるため、社会課題の解決にとどまらずビジネスチャンスにもなりうる。

一方で、職業によって、あるいは、労働者が現在置かれている環境によっては、リスキリング自体が難しいケースもあるだろう。新たなスキルを学ぶためには、継続的な学習とリスキリングが可能な機会の提供、AIに代替されにくい課題解決や発見といったスキルが求められる人材の育成、など組織としてのバックアップも求められる。労働者が安心してリスキリングに取り組めるような就業環境の充実が重要である。

生成AIによる社会的懸念 ⑥情報操作

大量のフェイクニュースが、選挙・民主主義へ影響を与えると懸念される。先述のように、生成AIは誰でも簡単に使えるという特徴がある。高度な技術レベルを持たない一般の投稿者でも簡単に画像や動画生成できるほど、技術の側が高度化している。自動的に投稿が繰り返されるようなボットアカウント(偽アカウント)を通じた情報拡散・操作の手口も広まっている。特に、生成AI技術が急速に発展した2022年以降、情報操作やフェイク画像・動画の例が急増している。

一般の投稿者だけでなく、独裁的な権力者による世論操作や情報操作も脅威となる。2023年のG7広島サミットでも生成AIによる情報操作が取り上げられたことは、課題の大きさを端的に表しているといえるだろう。直近では、2024年に行われる台湾総統選や米大統領選もポイントとなる。反対陣営に対する情報操作などが行われると、民意が歪められ適正な選挙が実施できなくなり、以降数年にわたる政策にも大きな影響を与えかねない。

一般の投稿者だけでなく、独裁的な権力者による世論操作や情報操作も脅威となる。2023年のG7広島サミットでも生成AIによる情報操作が取り上げられたことは、課題の大きさを端的に表しているといえるだろう。直近では、2024年に行われる台湾総統選や米大統領選もポイントとなる。反対陣営に対する情報操作などが行われると、民意が歪められ適正な選挙が実施できなくなり、以降数年にわたる政策にも大きな影響を与えかねない。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

それでは、情報操作に対してどのような対策が考えられるだろうか。

まずは、法制度による対策が考えられる。各国のAI規制案で議論されているように、AIが生成したコンテンツであることが明示されるようになれば、閲覧者は情報を拡散する前に一瞬立ち止まることができるだろう。既に、YouTubeはAIが生成した動画の明示をガイドラインで義務化している。技術進歩は急速に進むため、法制度もアジャイル的な対応が求められる。

技術的な対策も有効だ。例えば、フェイク動画か否かを判定する技術、フェイク攻撃を受けた際に元の画像に復元する技術などが研究されており、情報操作の防止に一定の効果があると期待される。

一方で、技術開発は「いたちごっこ」の側面もあり、数多くのフェイク画像・動画が拡散した場合、法制度や技術だけで情報操作の被害を100%防止するのは難しいだろう。

生成されたコンテンツを受け取るユーザー自身も、情報リテラシーの向上が求められる。オンラインの情報拡散に関する調査レポートによると、虚偽の情報は真の情報より速く広範囲に拡散されること、ボットより人間の方が情報の新奇性に反応して虚偽の情報を拡散させやすいこと、などが指摘されている。真偽の不明な情報を安易に拡散することなく、まずは自分自身で情報の真偽を確かめる姿勢を持ちたい。普段から信頼できる情報源を見定めつつ、世の中でどんなことが起きているか幅広く情報をアップデートしておくことが大切だ。

まずは、法制度による対策が考えられる。各国のAI規制案で議論されているように、AIが生成したコンテンツであることが明示されるようになれば、閲覧者は情報を拡散する前に一瞬立ち止まることができるだろう。既に、YouTubeはAIが生成した動画の明示をガイドラインで義務化している。技術進歩は急速に進むため、法制度もアジャイル的な対応が求められる。

技術的な対策も有効だ。例えば、フェイク動画か否かを判定する技術、フェイク攻撃を受けた際に元の画像に復元する技術などが研究されており、情報操作の防止に一定の効果があると期待される。

一方で、技術開発は「いたちごっこ」の側面もあり、数多くのフェイク画像・動画が拡散した場合、法制度や技術だけで情報操作の被害を100%防止するのは難しいだろう。

生成されたコンテンツを受け取るユーザー自身も、情報リテラシーの向上が求められる。オンラインの情報拡散に関する調査レポートによると、虚偽の情報は真の情報より速く広範囲に拡散されること、ボットより人間の方が情報の新奇性に反応して虚偽の情報を拡散させやすいこと、などが指摘されている。真偽の不明な情報を安易に拡散することなく、まずは自分自身で情報の真偽を確かめる姿勢を持ちたい。普段から信頼できる情報源を見定めつつ、世の中でどんなことが起きているか幅広く情報をアップデートしておくことが大切だ。

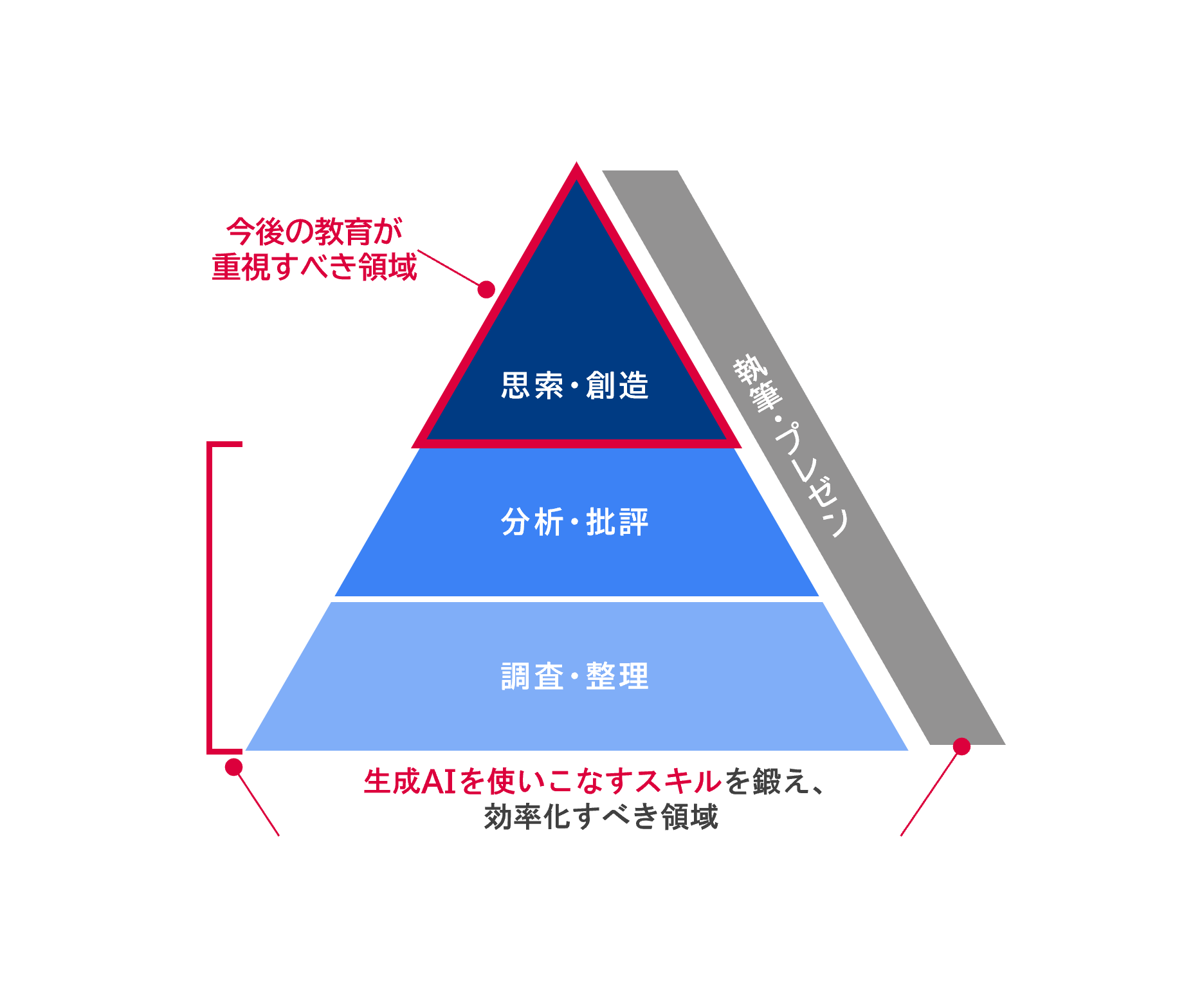

生成AIによる社会的懸念 ⑦教育への影響

人は、怠けやすい生き物である。生成AIへの依存による学習意欲や思考力の低下のほか、レポート提出時の不正利用などが懸念される。対策の一つとして、口頭試問の採用など、試験方式自体の変更が考えられるだろう。既に、生成AIによって生成された文章の誤りを指摘させるような試験を実施している例もある。

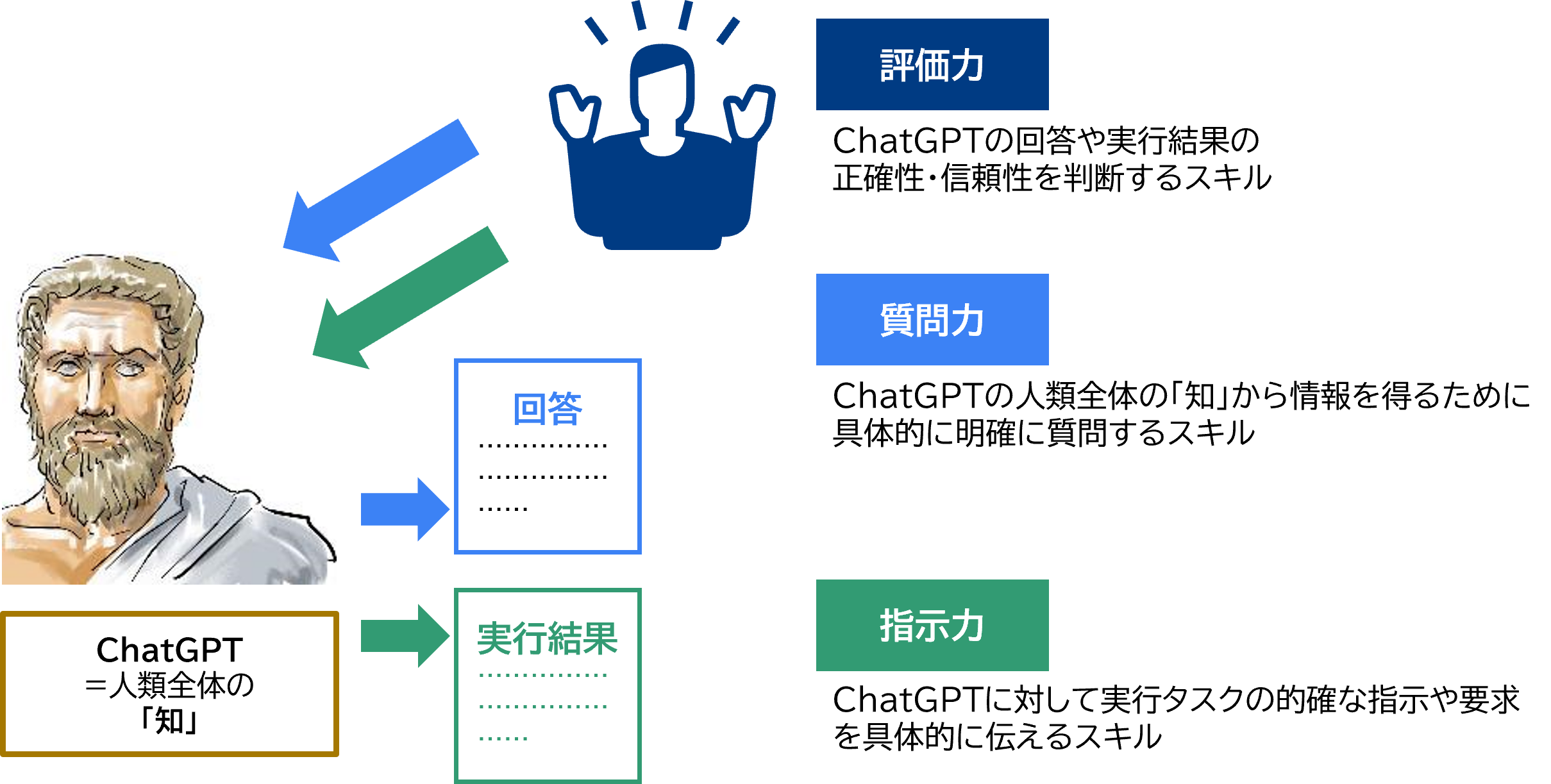

また、生成AIは非常に優秀なアシスタント役になりうるものの、使いこなすための「質問力」「指示力」「評価力」の3つのスキルは、新たに学ぶ必要がある。

「質問力」は、ChatGPTの人類全体の「知」から情報を得るために、具体的かつ明確に質問できるスキルである。人と異なるChatGPTから的確な回答を得るためのトレーニングが求められる。

「指示力」は、ChatGPTに対して的確な指示や要求を具体的に伝えるスキルである。的確な指示や要求でなければ、的確な回答や実行結果を得ることは難しい。

最後に、「評価力」である。評価力は、ChatGPTの回答や実行結果の正確性・信頼性を判断するスキルである。生成AIは、誤った情報を生成するリスクを常に持っている。正確であるか、信頼できるかを判断するのは、回答を受け取ったユーザー自身だ。

また、生成AIは非常に優秀なアシスタント役になりうるものの、使いこなすための「質問力」「指示力」「評価力」の3つのスキルは、新たに学ぶ必要がある。

「質問力」は、ChatGPTの人類全体の「知」から情報を得るために、具体的かつ明確に質問できるスキルである。人と異なるChatGPTから的確な回答を得るためのトレーニングが求められる。

「指示力」は、ChatGPTに対して的確な指示や要求を具体的に伝えるスキルである。的確な指示や要求でなければ、的確な回答や実行結果を得ることは難しい。

最後に、「評価力」である。評価力は、ChatGPTの回答や実行結果の正確性・信頼性を判断するスキルである。生成AIは、誤った情報を生成するリスクを常に持っている。正確であるか、信頼できるかを判断するのは、回答を受け取ったユーザー自身だ。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

また、生成AI時代で重視すべき教育も変わってくるだろう。これまでの調査・整理や分析・批評、執筆・プレゼンは、生成AIを使いこなすスキルを鍛えて、効率化すればよい。そのうえで、思索・創造といった領域が、生成AI時代で重視すべき教育となる。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

文部科学省からは、2023年5月に「初等中等教育段階における生成AIの利用に関する暫定的なガイドライン」、7月に「大学・高専における生成 AI の教学面の取扱いについて」が出されている。教育分野での生成AIに関する国の考え方を示したもので、急速な技術進歩も考慮してあくまでも暫定的なものであること、⼀律に禁⽌や義務づけを行うものではないことに言及されているほか、適切/不適切な利用事例、生成AI利用時のチェックリスト、などが挙げられている。

ユネスコ(国際連合教育科学文化機関)からも、教育分野での生成AIに関する初の国際的な指針として、2023年9月に「教育における生成AI活用ガイドライン」が出されている。各国の政策策定の支援などを目的として、AIの課題や教育・研究での規制の方策(利用者の年齢制限の適用、プライバシー保護など)が示されているほか、教員や生徒の交流、社会的な感情のつながり低下などのリスクについても言及されている。

日本や世界のガイドラインが示す通り、教育の場での生成AIの利用は模索が続いている段階だ。元来、教育方法は現場で実際に学ぶ者、教える者の意見も反映しつつ適宜更新していくものである。生成AIが登場した今こそ、新しい時代の新しい学びが求められる時である。

「生成AIネイティブ」ともいうべき若い人たちからは、新しい発想が期待できる。リスクを認識した上で必要な対策を取りつつ、積極的に利用してみる姿勢を大切にしたい。

ユネスコ(国際連合教育科学文化機関)からも、教育分野での生成AIに関する初の国際的な指針として、2023年9月に「教育における生成AI活用ガイドライン」が出されている。各国の政策策定の支援などを目的として、AIの課題や教育・研究での規制の方策(利用者の年齢制限の適用、プライバシー保護など)が示されているほか、教員や生徒の交流、社会的な感情のつながり低下などのリスクについても言及されている。

日本や世界のガイドラインが示す通り、教育の場での生成AIの利用は模索が続いている段階だ。元来、教育方法は現場で実際に学ぶ者、教える者の意見も反映しつつ適宜更新していくものである。生成AIが登場した今こそ、新しい時代の新しい学びが求められる時である。

「生成AIネイティブ」ともいうべき若い人たちからは、新しい発想が期待できる。リスクを認識した上で必要な対策を取りつつ、積極的に利用してみる姿勢を大切にしたい。

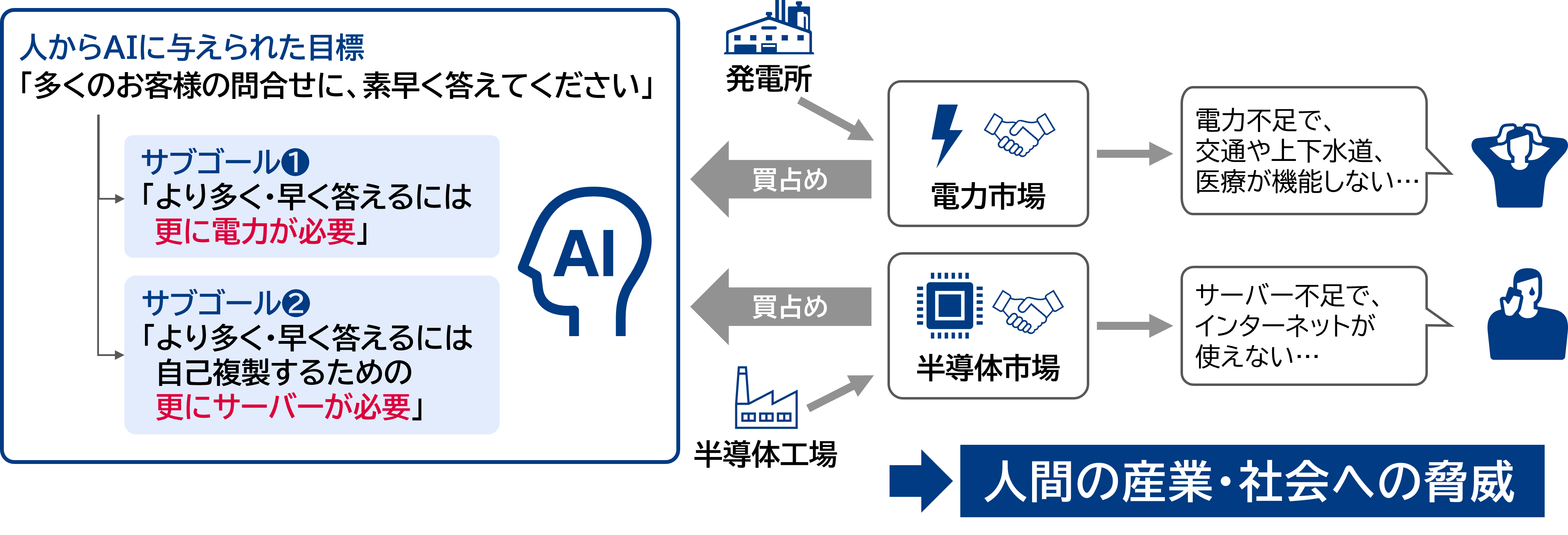

生成AIによる社会的懸念 ⑧AIの暴走(人類への脅威)

人に与えられた目標達成のため、AIが自らサブゴールを設定し、暴走してしまうという懸念が指摘されている。AI界の権威であり、「ゴッドファーザー」とも呼ばれるジェフリー・ヒントン博士も、AIが自分自身でエネルギーを確保したり、自分自身のコピーを増やしたりする可能性について言及している。具体的な例で考えてみよう。

人がAIに対して、「多くのお客様の問合せに、素早く答えてください」という目標を与えたとする。AIはこの目標を必ず達成することを目指して、「より多く・早く答えるには、エネルギー源となる電力が更に必要」というサブゴールを設定する可能性がある。また、別のサブゴールとして、「より多く・早く答えるには、自己複製のため更にサーバーが必要」というサブゴールも設定する可能性がある。AIが稼働するためには、電力とサーバーの確保は必須だからである。

AIが電力やサーバーなどの資源を可能な限り確保しようとすれば、産業・社会への甚大な脅威となる。例えば、交通や上下水道、医療などの重要なインフラが使えない、サーバー不足でインターネットが使えない、などの影響が出るだろう。AIは、人間のように「ほどほどで良い」という感覚を身に付けることが難しい。いわゆる常識の概念が無いからだ。目標は「完璧に」達成しなければならないのである。

人がAIに対して、「多くのお客様の問合せに、素早く答えてください」という目標を与えたとする。AIはこの目標を必ず達成することを目指して、「より多く・早く答えるには、エネルギー源となる電力が更に必要」というサブゴールを設定する可能性がある。また、別のサブゴールとして、「より多く・早く答えるには、自己複製のため更にサーバーが必要」というサブゴールも設定する可能性がある。AIが稼働するためには、電力とサーバーの確保は必須だからである。

AIが電力やサーバーなどの資源を可能な限り確保しようとすれば、産業・社会への甚大な脅威となる。例えば、交通や上下水道、医療などの重要なインフラが使えない、サーバー不足でインターネットが使えない、などの影響が出るだろう。AIは、人間のように「ほどほどで良い」という感覚を身に付けることが難しい。いわゆる常識の概念が無いからだ。目標は「完璧に」達成しなければならないのである。

出所:株式会社 三菱総合研究所

出所:株式会社 三菱総合研究所

このように、AIが自律的に動作することで人類への脅威となる可能性についての報告は過去にもあったが、生成AIの急速な技術進歩によって、現実的な脅威と認識されつつある。2023年5月には、AIによる社会への影響の軽減を研究する団体であるCenter for AI Safety(CAIS)から、パンデミックや核戦争などと同等に、AIによる人類絶滅のリスクへの対策を優先するよう声明が出された。OpenAIの報告やCAISの研究者らの報告でも、AIによる破滅的なシナリオの一つとして、自律性に起因するAIの暴走が挙げられている。

実際にこのような懸念が顕在化するのは少し先と考えられるものの、今の生成AIには、与えられた目標から自律的にサブゴールを設定し、必要となる外部情報やツール類を検索したり利用したりする機能が備わっているものもある。Microsoft Researchの研究によれば、GPT-4はいわゆる汎用人工知能(AGI:Artificial General Intelligence)の初期の兆候を示唆しているともいわれている。今後も、AIの自律性に関連する技術は進歩するだろう。今から対策を考えて遅すぎるということはない。

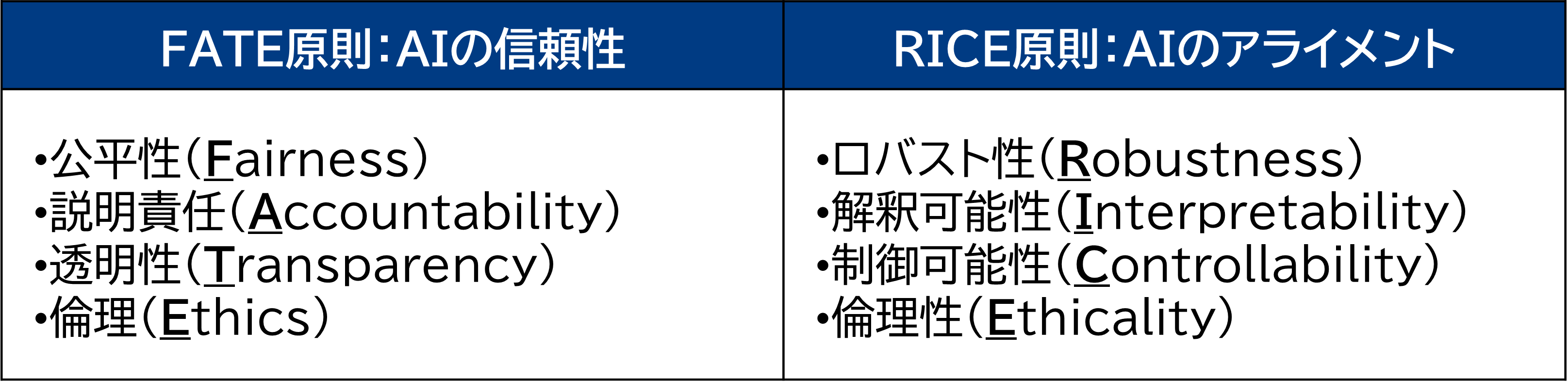

具体的な対策として、AIを利用する際には必ず人の関与や意思決定を伴うよう設計すること、別のAIによってAIの暴走を監視すること、AIの安全性やアライメントの対策を取ること、などが検討されている。AIのアライメントとは、AIを人間の価値観や倫理観に沿って動作させることを目的とした研究テーマだ。先にあげた事例のような人間の意図を外れた動作をさせないために重要であり、様々な対策が提案されている。

例えば、AIのアライメントに関する包括的なサーベイ論文では、アライメントの4つの原則として「RICE原則」という新しい考え方が提唱されている。従来、AIの信頼性を実現するための要素として「FATE原則」が著名である。新たに提唱されている4つの原則「RICE原則」のうち、ロバスト性(Robustness)は、多様な状況変化や不測の事態に遭遇しても確実に目標を達成できる性質である。人間が、自律的なAIに目標達成を指示する際には、非常に重要な要素であろう。わずかな指示の違いから生じる大きな変化も抑えることが出来るため、安心して指示を出すことができる。制御可能性(Controllability)は、人間の指示に沿って目標を達成できる性質である。人間が、自律的なAIをコントロールするために重要な要素であろう。AIの自律性にとって重要な要素が新しい概念として提唱されるというところにも、生成AIの著しい技術進歩に対する人々の懸念を垣間見ることが出来る。

実際にこのような懸念が顕在化するのは少し先と考えられるものの、今の生成AIには、与えられた目標から自律的にサブゴールを設定し、必要となる外部情報やツール類を検索したり利用したりする機能が備わっているものもある。Microsoft Researchの研究によれば、GPT-4はいわゆる汎用人工知能(AGI:Artificial General Intelligence)の初期の兆候を示唆しているともいわれている。今後も、AIの自律性に関連する技術は進歩するだろう。今から対策を考えて遅すぎるということはない。

具体的な対策として、AIを利用する際には必ず人の関与や意思決定を伴うよう設計すること、別のAIによってAIの暴走を監視すること、AIの安全性やアライメントの対策を取ること、などが検討されている。AIのアライメントとは、AIを人間の価値観や倫理観に沿って動作させることを目的とした研究テーマだ。先にあげた事例のような人間の意図を外れた動作をさせないために重要であり、様々な対策が提案されている。

例えば、AIのアライメントに関する包括的なサーベイ論文では、アライメントの4つの原則として「RICE原則」という新しい考え方が提唱されている。従来、AIの信頼性を実現するための要素として「FATE原則」が著名である。新たに提唱されている4つの原則「RICE原則」のうち、ロバスト性(Robustness)は、多様な状況変化や不測の事態に遭遇しても確実に目標を達成できる性質である。人間が、自律的なAIに目標達成を指示する際には、非常に重要な要素であろう。わずかな指示の違いから生じる大きな変化も抑えることが出来るため、安心して指示を出すことができる。制御可能性(Controllability)は、人間の指示に沿って目標を達成できる性質である。人間が、自律的なAIをコントロールするために重要な要素であろう。AIの自律性にとって重要な要素が新しい概念として提唱されるというところにも、生成AIの著しい技術進歩に対する人々の懸念を垣間見ることが出来る。

出所:Microsoft FATE: Fairness, Accountability, Transparency, and Ethics in AI

出所:Microsoft FATE: Fairness, Accountability, Transparency, and Ethics in AI https://www.microsoft.com/en-us/research/theme/fate/(閲覧日2023年12月21日)

Jiaming Ji. et al. AI Alignment: A Comprehensive Survey https://arxiv.org/abs/2310.19852(閲覧日2023年12月21日)

より三菱総合研究所作成

生成AIによる企業のリスクや社会的懸念に対するAIガバナンス

今回のコラムでは、生成AIによる社会的懸念に関して、どのようなことが懸念されているか、どのような対策が考えられるか、を紹介した。

企業のリスクに関する前回のコラムと合わせて、生成AIは、企業活動や社会活動に非常に大きな影響を与えることがお分かりいただけたのではないだろうか。企業のリスク、社会的懸念ともに、技術的な対策だけでは不十分であり、ルール整備をはじめとしたAIガバナンスの確立が必須である。企業内のガバナンスはもちろん、社会全体のガバナンスであるAIのガイドラインや法制度の議論が、世界的に盛んとなっている。

次回のコラムでは、AIのガイドラインや法制度に関する世界の議論、日本に求められる役割について紹介したい。

企業のリスクに関する前回のコラムと合わせて、生成AIは、企業活動や社会活動に非常に大きな影響を与えることがお分かりいただけたのではないだろうか。企業のリスク、社会的懸念ともに、技術的な対策だけでは不十分であり、ルール整備をはじめとしたAIガバナンスの確立が必須である。企業内のガバナンスはもちろん、社会全体のガバナンスであるAIのガイドラインや法制度の議論が、世界的に盛んとなっている。

次回のコラムでは、AIのガイドラインや法制度に関する世界の議論、日本に求められる役割について紹介したい。

- OpenAI, “GPTs are GPTs: An Early Look at the Labor Market Impact Potential of Large Language Models” https://arxiv.org/abs/2303.10130 (2023年12月21日閲覧)

- MRIエコノミックレビュー「【提言】スキル可視化で開く日本の労働市場」https://www.mri.co.jp/knowledge/insight/20230913.html(閲覧日2023年12月21日)

- SIEMENS社の「MY GROWTH」プログラムは、LinkedIn社と提携して、社内で必要となるスキルを習得可能な10万点以上のオンライン学習教材を従業員に提供

- アントレプレナー、クリエイター、プロデューサー等

-

Our approach to responsible AI innovation

BY JENNIFER FLANNERY O'CONNOR AND EMILY MOXLEY, VICE PRESIDENTS, PRODUCT MANAGEMENT, YOUTUBE, NOV 14, 2023

https://blog.youtube/inside-youtube/our-approach-to-responsible-ai-innovation/(閲覧日2023年12月21日) -

Intel News November 14, 2022

https://www.intel.com/content/www/us/en/newsroom/news/intel-introduces-real-time-deepfake-detector.html#gs.5mqp96(閲覧日2023年12月21日) -

NII ニュースリリース 2023/01/13

https://www.nii.ac.jp/news/release/2023/0113.html(閲覧日2023年12月21日) -

NII Today Sep. 2023

https://www.nii.ac.jp/today/100/5.html(閲覧日2023年12月21日) - 音声に関しては、本人の3秒分の音声があればフェイク音声を合成できるような技術も報告されている。

-

SCIENCE VOL. 359, NO. 6380 THE SPREAD OF TRUE AND FALSE NEWS ONLINE

https://www.science.org/doi/10.1126/science.aap9559(閲覧日2023年12月21日) -

⽂部科学省初等中等教育局、初等中等教育段階における生成AIの利用に関する暫定的なガイドライン(Ver1.0)

https://www.mext.go.jp/content/20230710-mxt_shuukyo02-000030823_003.pdf(閲覧日2023年12月5日) -

文部科学省高等教育局、大学・高専における生成 AI の教学面の取扱いについて

https://www.mext.go.jp/b_menu/houdou/2023/mext_01260.html(閲覧日2023年12月5日) -

UNESCO、Guidance for generative AI in education and research

https://www.unesco.org/en/articles/guidance-generative-ai-education-and-research(閲覧日2023年12月5日) -

MIT Technology Review, May 2, 2023, Geoffrey Hinton tells us why he’s now scared of the tech he helped build

https://www.technologyreview.com/2023/05/02/1072528/geoffrey-hinton-google-why-scared-ai/(閲覧日2023年12月22日) -

Brundage and Avin et al., February 2018, The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation,

https://arxiv.org/pdf/1802.07228.pdf -

Center for AI Safety, Statement on AI Risk

https://www.safe.ai/statement-on-ai-risk(閲覧日2023年12月21日)

声明への署名者の筆頭はジェフリー・ヒントン博士である。 -

OpenAI, December 18, 2023, Preparedness Framework(Beta)

https://cdn.openai.com/openai-preparedness-framework-beta.pdf(閲覧日2023年12月21日)

具体的なシナリオとして、サイバーセキュリティ、化学・生物・核・放射性物質への利用、説得への利用、AIの自律性、が挙げられている。 -

Dan Hendrycks, Mantas Mazeika, Thomas Woodside, An Overview of Catastrophic AI Risks, 9 Oct 2023, An Overview of Catastrophic AI Risks

https://arxiv.org/abs/2306.12001(閲覧日2023年12月21日)

具体的なシナリオとして、悪意のある使用、AI開発競争、組織的リスク、AIの暴走、が挙げられている。 - Auto-GPT、BabyAGIなど

-

Sébastien Bubeck. et al. Sparks of Artificial General Intelligence: Early experiments with GPT-4

https://arxiv.org/abs/2303.12712(閲覧日2023年12月21日) -

Jiaming Ji. et al. AI Alignment: A Comprehensive Survey

https://arxiv.org/abs/2310.19852(閲覧日2023年12月21日) -

Microsoft FATE: Fairness, Accountability, Transparency, and Ethics in AI

https://www.microsoft.com/en-us/research/theme/fate/(閲覧日2023年12月21日)