三菱総合研究所は生成AI時代の始まりに向け「生成AIラボ」を新設する。それを記念して「三菱総研 生成AIコラム」の連載をお届けする。

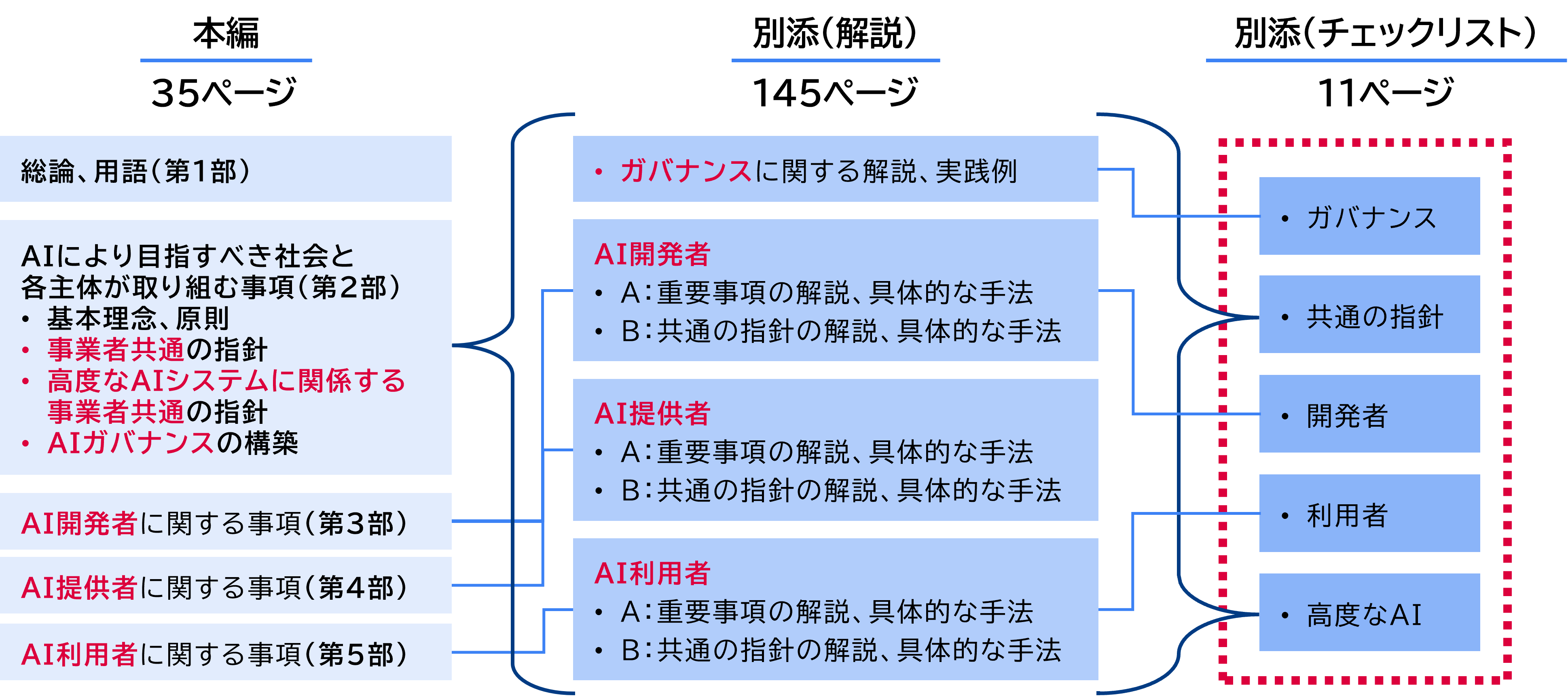

第3部第4回のコラムでは、2023年12月に公表された日本のAI事業者ガイドライン案(以下、ガイドライン案)について、5つの特徴や文書の構成、今後の課題などを解説した。

今回のコラムでは、企業が対応する際のポイントを解説する。

今回のコラムでは、企業が対応する際のポイントを解説する。

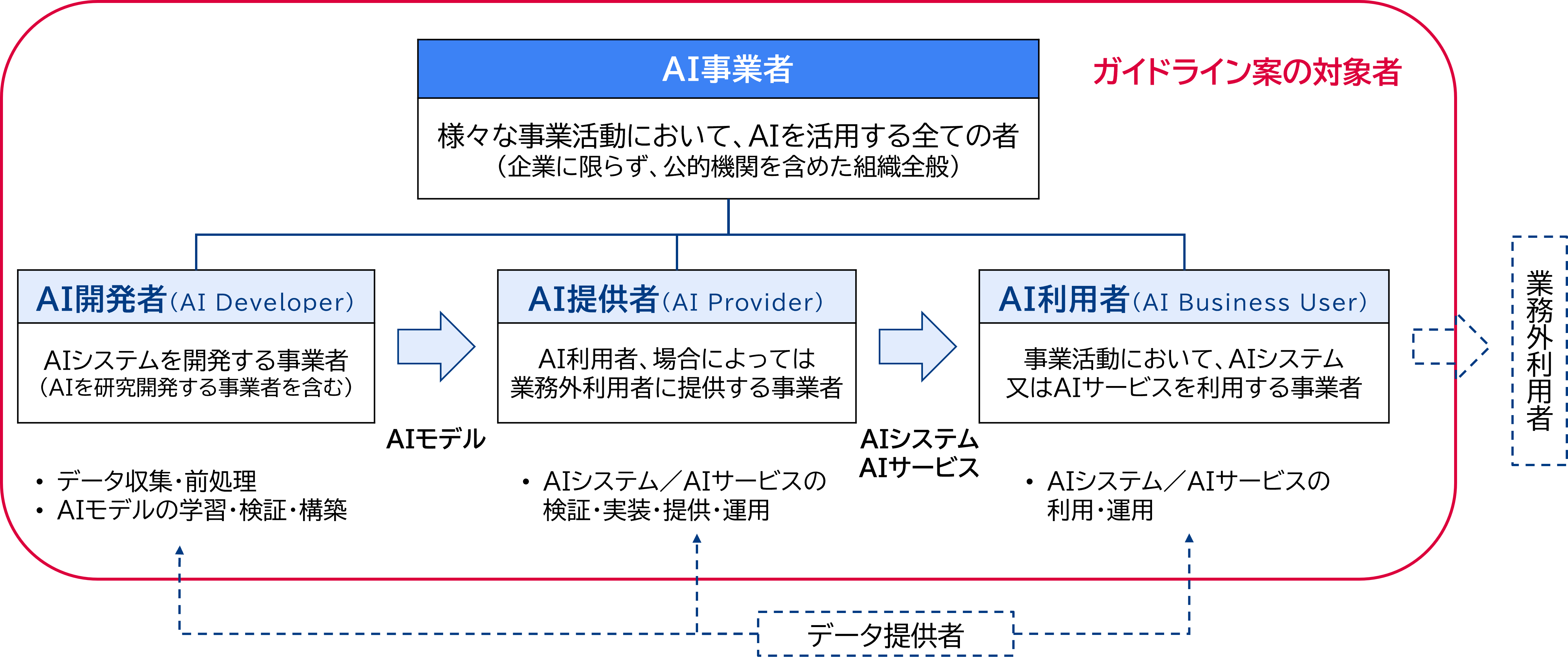

ガイドライン案の3つの事業者主体であるAI開発者、AI提供者、AI利用者のうち、本コラムでは特に、シリーズ第1部、第2部を通じて取り上げてきたAI利用者を中心に対応のポイントを解説する。AI利用者は、自社のAI利用にとどまらず、ガイドライン案の対象外とされている業務外利用者にも便益やリスクを与える主体である。AI利用者の対策によって、企業のリスクや社会的懸念はかなり緩和できる。

なお、本コラムの最後には、AI開発者、AI提供者についてもガイドライン案で記載されている具体的な手法を整理した。適宜参考としてほしい。

なお、本コラムの最後には、AI開発者、AI提供者についてもガイドライン案で記載されている具体的な手法を整理した。適宜参考としてほしい。

出所:AI事業者ガイドライン案より三菱総合研究所作成

出所:AI事業者ガイドライン案より三菱総合研究所作成

事業者がガイドラインに対応すべきものは、事業者として全社的に対応すべきガバナンスの構築と、事業展開している個別AIごとに対応すべきリスクの対応と、2つに分けることができる。前者については、ガイドライン案でガバナンスの実践のポイント、具体的な実践例などを多く紹介している。ガバナンスの構築時には参考としたい。本コラムでは、主に後者の個別AIのリスク対応について、AI利用者の視点から解説する。

なお、本コラムは2024年2月時点のパブリックコメント段階のガイドライン案の情報をもとにしている。ガイドライン案は、今後も適宜更新される「Living Document」とされている。ガイドライン案の内容は変わる可能性があることに留意が必要である。

今回公表されたガイドライン案は、AI事業に関係する全てのAI事業者が事業展開する際の指針となるものである。改めて、ガイドライン案の目的を確認しておこう。

第3部第1回、第2回のコラムで紹介したとおり、生成AIは、従来のAIにはなかったような新たなリスクや懸念が指摘されている。ガイドライン案には、既存の指針やガイドラインだけでは不十分であり、対策強化が求められているという認識が反映されている。

そのうえで、「イノベーションの促進とライフサイクルにわたるリスクの緩和を両立する枠組みを積極的に共創していくことを目指す」こととされている。あくまでも、AIのリスクは受容可能な水準で管理しつつ、イノベーションを促進するためのガイドラインという位置づけだ。

本コラムでは、この目的を達成する手順として、以下の手順を解説する。

第3部第1回、第2回のコラムで紹介したとおり、生成AIは、従来のAIにはなかったような新たなリスクや懸念が指摘されている。ガイドライン案には、既存の指針やガイドラインだけでは不十分であり、対策強化が求められているという認識が反映されている。

そのうえで、「イノベーションの促進とライフサイクルにわたるリスクの緩和を両立する枠組みを積極的に共創していくことを目指す」こととされている。あくまでも、AIのリスクは受容可能な水準で管理しつつ、イノベーションを促進するためのガイドラインという位置づけだ。

本コラムでは、この目的を達成する手順として、以下の手順を解説する。

手順① 体制とコストの検討

手順② 一般的なリスクの把握

手順③ 対応すべきリスクと手法の選定

手順④ 運用(モニタリング)、評価

手順⑤ 体制とコストの再検討(手順①に戻る)

手順② 一般的なリスクの把握

手順③ 対応すべきリスクと手法の選定

手順④ 運用(モニタリング)、評価

手順⑤ 体制とコストの再検討(手順①に戻る)

手順① 体制とコストの検討

ガイドライン案への対応に際して、手順②以降を実施するための体制とコストが必要となる。ただし、各企業が割けるリソースやコストには限界がある。いきなり大掛かりなものを構築せずに、スモールスタートが良い。

既にAI事業を展開している事業者は、本ガイドライン案が公表される前から、既存のガイドラインに対応する所管組織があるはずだ。まずは所管組織の拡充や改編で対応できる可能性を検討したい。前回のコラムで解説したとおり、本ガイドライン案は既存のガイドライン案を統合・見直しした内容となっている。既存のガイドラインに対応した際の体制やメンバーが残っている場合は、当時の知見を活用することも有効だ。

冒頭で述べた2種の対応に即して、対応部署を分けることも選択肢となる。全社的に対応すべきガバナンスはリスク管理・ステークホルダー対応・セキュリティ対策などを所管する部署が、個別AIごとのリスク対応は事業部でAI事業を担う部署や事業化審査を担う部署が、それぞれ該当する。

既にAI事業を展開している事業者は、本ガイドライン案が公表される前から、既存のガイドラインに対応する所管組織があるはずだ。まずは所管組織の拡充や改編で対応できる可能性を検討したい。前回のコラムで解説したとおり、本ガイドライン案は既存のガイドライン案を統合・見直しした内容となっている。既存のガイドラインに対応した際の体制やメンバーが残っている場合は、当時の知見を活用することも有効だ。

冒頭で述べた2種の対応に即して、対応部署を分けることも選択肢となる。全社的に対応すべきガバナンスはリスク管理・ステークホルダー対応・セキュリティ対策などを所管する部署が、個別AIごとのリスク対応は事業部でAI事業を担う部署や事業化審査を担う部署が、それぞれ該当する。

手順② 一般的なリスクの把握

手順②では、自社が対応すべきリスクを特定するため、可能性のあるリスクを洗い出す。生成AIも含め、AI一般のリスクについて把握することから始めるのが良いだろう。一般的に指摘されているリスクや、自社事業の中で把握しているリスクから絞り込んでいく方法が有効だ。

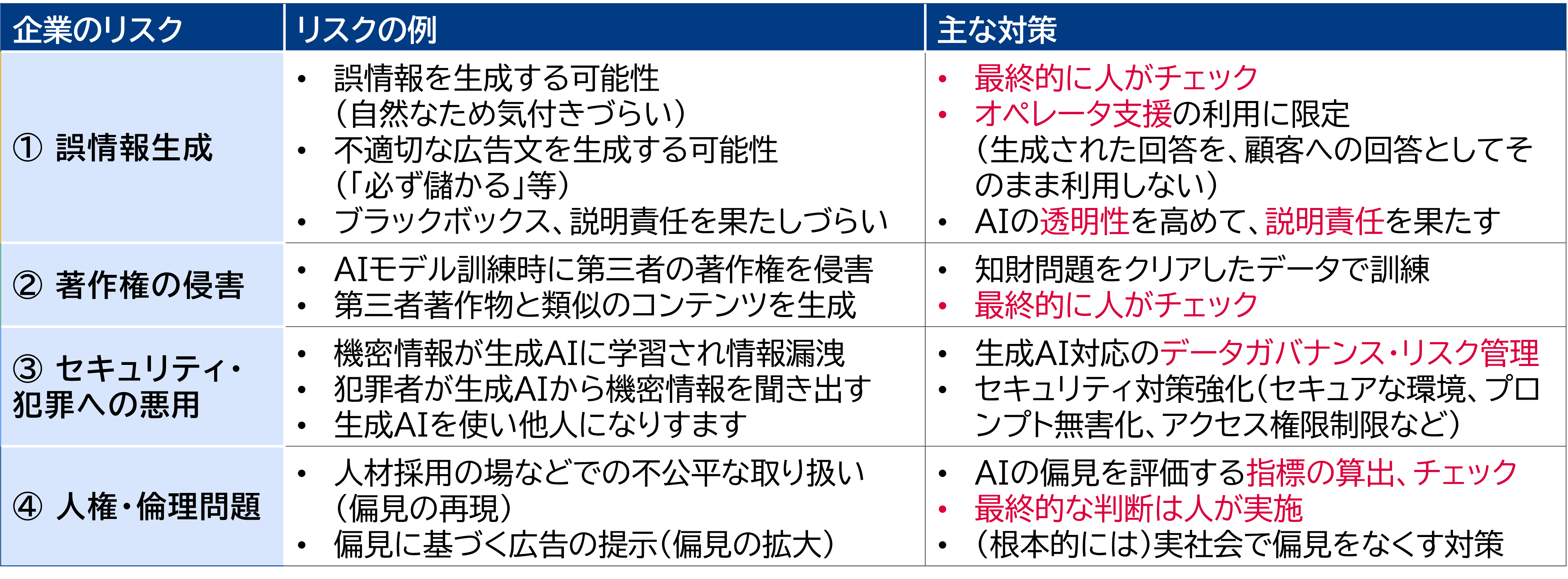

一般的に指摘されているリスクに関しては、例えば本コラムシリーズで、4つの企業のリスク「①誤情報生成」「②著作権の侵害」「③セキュリティ・犯罪への悪用」「④人権・倫理問題」を取り上げている。主な対策も解説しているので参考としてほしい。

出所:本コラムシリーズより三菱総合研究所作成

出所:本コラムシリーズより三菱総合研究所作成

ガイドライン案でも、AI全般のリスクのほか、生成AI特有のリスクの例として、「悪用」「機密情報の流出」「ハルシネーション」「偽情報、誤情報を鵜呑みにすること」「著作権との関係」「資格等との関係」「バイアスの再生成」を挙げている。また、AIのリスクに関するデータベースも紹介されている。

出所:AI事業者ガイドライン案より三菱総合研究所作成

出所:AI事業者ガイドライン案より三菱総合研究所作成

一般的なリスクに関しては、これらの俯瞰的に整理された情報をベースに検討するのが良い。

自社事業の中で把握しているリスクに関しては、手順①で挙げたリスク管理部署やAI事業を所管する部署などに蓄積されている知見がベースとなる。

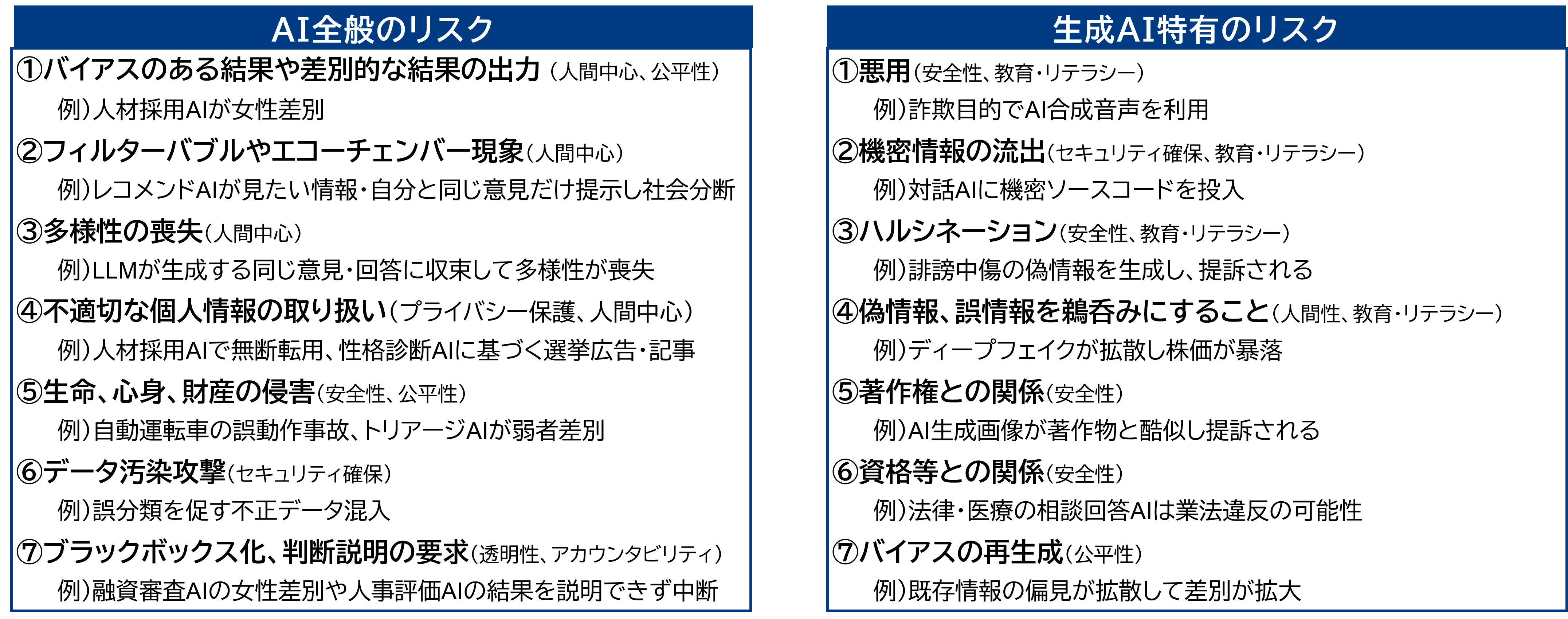

当社のアンケート調査から、実務でのリスクの認識を見てみよう。

当社では、AI事業を展開している企業に対して、2023年6月と12月にアンケート調査を実施している。生成AI関連サービス(ChatGPT等)で懸念していることとしては、「アウトプットされる回答情報の誤り、正確性」「著作権、知財権、プライバシー侵害などの法的リスク」「機密情報の漏洩リスク」といった回答が多くなっている。6月時点と12月時点の回答結果を比較すると、「アウトプットされる回答情報の誤り、正確性」の懸念が減少している(54.0%⇒47.0%)。誤情報のリスクに対応する技術や知見の蓄積によって、懸念が若干緩和されている可能性がある。生成AIの技術進歩は非常に速い。第9回コラムでも当社の「ロボリサ®」などリスク対応のサービスを幾つか紹介したが、普段から技術情報の収集は必須だ。

当社のアンケート調査から、実務でのリスクの認識を見てみよう。

当社では、AI事業を展開している企業に対して、2023年6月と12月にアンケート調査を実施している。生成AI関連サービス(ChatGPT等)で懸念していることとしては、「アウトプットされる回答情報の誤り、正確性」「著作権、知財権、プライバシー侵害などの法的リスク」「機密情報の漏洩リスク」といった回答が多くなっている。6月時点と12月時点の回答結果を比較すると、「アウトプットされる回答情報の誤り、正確性」の懸念が減少している(54.0%⇒47.0%)。誤情報のリスクに対応する技術や知見の蓄積によって、懸念が若干緩和されている可能性がある。生成AIの技術進歩は非常に速い。第9回コラムでも当社の「ロボリサ®」などリスク対応のサービスを幾つか紹介したが、普段から技術情報の収集は必須だ。

出所:三菱総合研究所調査

出所:三菱総合研究所調査

12月の調査では、実際に起きている問題として、約14%の企業が「著作権、知財権、プライバシー侵害などで社内外から指摘が入った」と回答、約23%の企業が「情報漏洩リスクがケアしきれずに、リスク管理部署から指摘が入った」とも回答している。生成AIの利用が広がり、リスクが顕在化する機会が増えたことも一つの要因と考えられる。著作権をはじめ、生成AIに関連する法制度の議論はまさに進行中の状況だ。技術情報だけでなく、法制度も情報収集に努めたい。

手順③ 対応すべきリスクと手法の選定

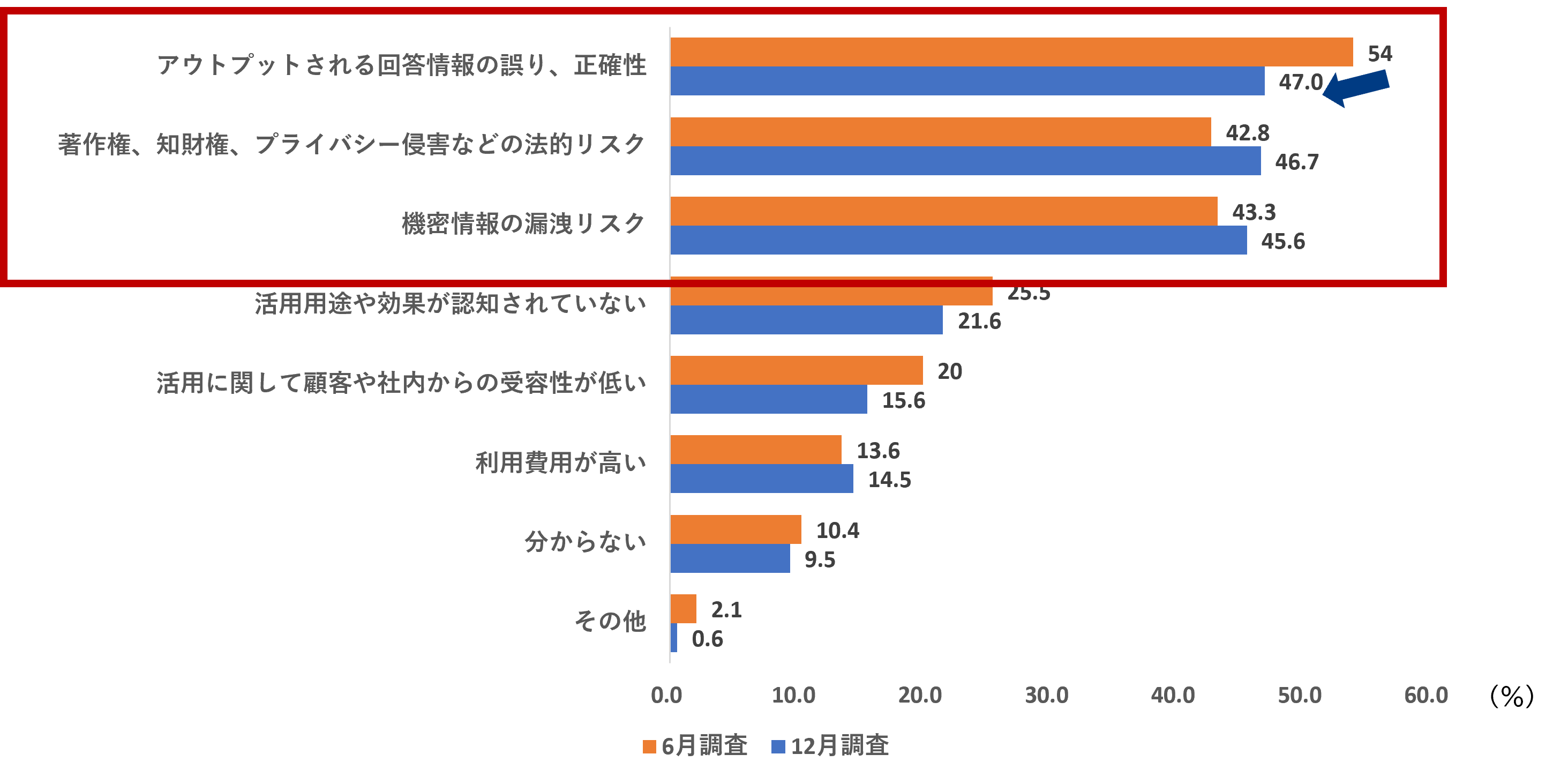

自社が対応すべきリスクと手法の選定に際しては、ガイドライン案と、ガイドライン案に添付されているチェックリストを最大限活用したい。手順②で把握したリスクから、対応すべきものを、優先度を付けて絞り込むのが良い。

ガイドライン案は、約200頁の大部の文書である。別添(解説)を中心に、主体別の具体的な手法が多数記載されている。別添(解説)Aでは本編の主体別の重要事項の解説と具体的な手法、別添(解説)Bでは本編の共通の指針で当該主体が特に意識すべき事項と具体的な手法、が整理されている。手法選定の際には参考としたい情報だ。

実務上は、別添のチェックリストの活用が有効になる。各主体別に手法が整理されているためわかりやすく、対応状況のモニタリングにも活用できる。事業者は、リスク対応の優先度に応じてチェックリストをカスタマイズするのが良い。なお、ガイドライン案では、事業者の事業に応じて対策を取捨選択する必要があること、すべての対策を実施するものではないことも述べられている。

実務上は、別添のチェックリストの活用が有効になる。各主体別に手法が整理されているためわかりやすく、対応状況のモニタリングにも活用できる。事業者は、リスク対応の優先度に応じてチェックリストをカスタマイズするのが良い。なお、ガイドライン案では、事業者の事業に応じて対策を取捨選択する必要があること、すべての対策を実施するものではないことも述べられている。

出所:AI事業者ガイドライン案より三菱総合研究所作成

出所:AI事業者ガイドライン案より三菱総合研究所作成

具体的な例として、生成AIを用いたECサイト運営事業を考えてみよう。

この事業では、生成AIは、ECサイトで商品を購入する顧客に対して商品情報や推薦文を生成する。事業者であるAI利用者は、AI開発者が開発・AI提供者から提供された生成AIを用いて、顧客(業務外利用者)に便益とリスクを与える主体となる。ガイドライン案でも紹介されているRAG(Retrieval-Augmented Generation)などの技術を使えば、事業者内に蓄積されている商品のカタログ情報や顧客のレビュー情報をもとに、顧客からの問い合わせに対して応答文を生成することができる。

この事業では、生成AIは、ECサイトで商品を購入する顧客に対して商品情報や推薦文を生成する。事業者であるAI利用者は、AI開発者が開発・AI提供者から提供された生成AIを用いて、顧客(業務外利用者)に便益とリスクを与える主体となる。ガイドライン案でも紹介されているRAG(Retrieval-Augmented Generation)などの技術を使えば、事業者内に蓄積されている商品のカタログ情報や顧客のレビュー情報をもとに、顧客からの問い合わせに対して応答文を生成することができる。

以下、この事業でのリスク対応の例を挙げる。自社の事業内容と対応可能なリソース状況を考慮して対策(具体的な手法)を選定するのが良い。

【安全性(誤情報)】

本コラムシリーズでも紹介したように、生成AIの応答文に100%の正確性を期待することは難しい。顧客に誤った情報や推薦文を生成してしまう「誤情報生成」リスクが想定される。ガイドライン案では、AI提供者の想定範囲で利用、最新性担保、精度やリスク理解などの対応が記載されている。AI提供者に対して、問い合わせ内容・検索された情報・応答文の整合性をチェックしているか確認を取ることが対策となる。また、精度向上には生成AIの出力を別の手法や生成時とは異なるプロンプトで検証する対策も有効である。ただし、精度向上にも限界がある。最終的に人がチェックするなどの対策も取り入れ、手続きとしてチェックリストをカスタマイズするのが良い。

【公平性(AIの偏見)】

顧客の属性(性別、年齢、居住地、職業、学歴、国籍など)に応じた回答を行っている場合には、本コラムシリーズでも取り上げたAIによる「偏見の再現」「偏見の拡大」のリスクが生じうる。AI提供者に、AIの偏見が起こっていないことを検証するよう求めることが対策の一つとなる。

【プライバシー保護】

顧客が問い合わせ時に個人情報を入力し、生成AIが学習、その後の別の問い合わせで情報漏洩してしまうリスクが想定される。個人情報が入力された場合の対処法をAI開発者やAI提供者と協議すること、不必要な個人情報を入力しないよう顧客(業務外利用者)に周知すること、などが対策となる。

【セキュリティ確保】

ECサイトの生成AIの脆弱性を狙ったプロンプトインジェクションなどのセキュリティリスクも想定される。攻撃者が悪意を持ったプロンプトを入力し、生成AIに不正なコマンドを実行させたりマルウェアを配置したりすることで、社内システムのデータ改ざん、削除、サービス妨害などを行う攻撃だ。機微情報の漏洩も懸念される。対策としては、AI提供者に、悪意のあるプロンプトの無害化が実施されているか確認することが考えられる。また、セキュアな環境の用意、アクセス権限の制限なども有効な対策となる。

【透明性・アカウンタビリティ(情報提供・説明)】

ガイドライン案では、ステークホルダーに対する透明性・アカウンタビリティの重要性にも言及している。このECサイト運営事業では、顧客へ生成AIを利用した応答であることを周知し、AI事業に対する企業方針の公表も検討すると良い。既に企業方針を整備済みであれば、今回のガイドライン案に合わせてアップデートすべきだ。

【教育・リテラシー】

AI事業を展開する事業者は、自社の社員がAIを扱う機会も多くなる。JDLA(一般社団法人日本ディープラーニング協会)からは、「生成AIの利用ガイドライン」も公開されており、企業内の利用ルールを策定する際は参考となる。ガイドライン案では、教育・リスキリングやAIリテラシーの確保の対応も挙げられている。生成AIのリスクを理解したうえで利用できるよう、社員への教育研修なども実施すると良い。

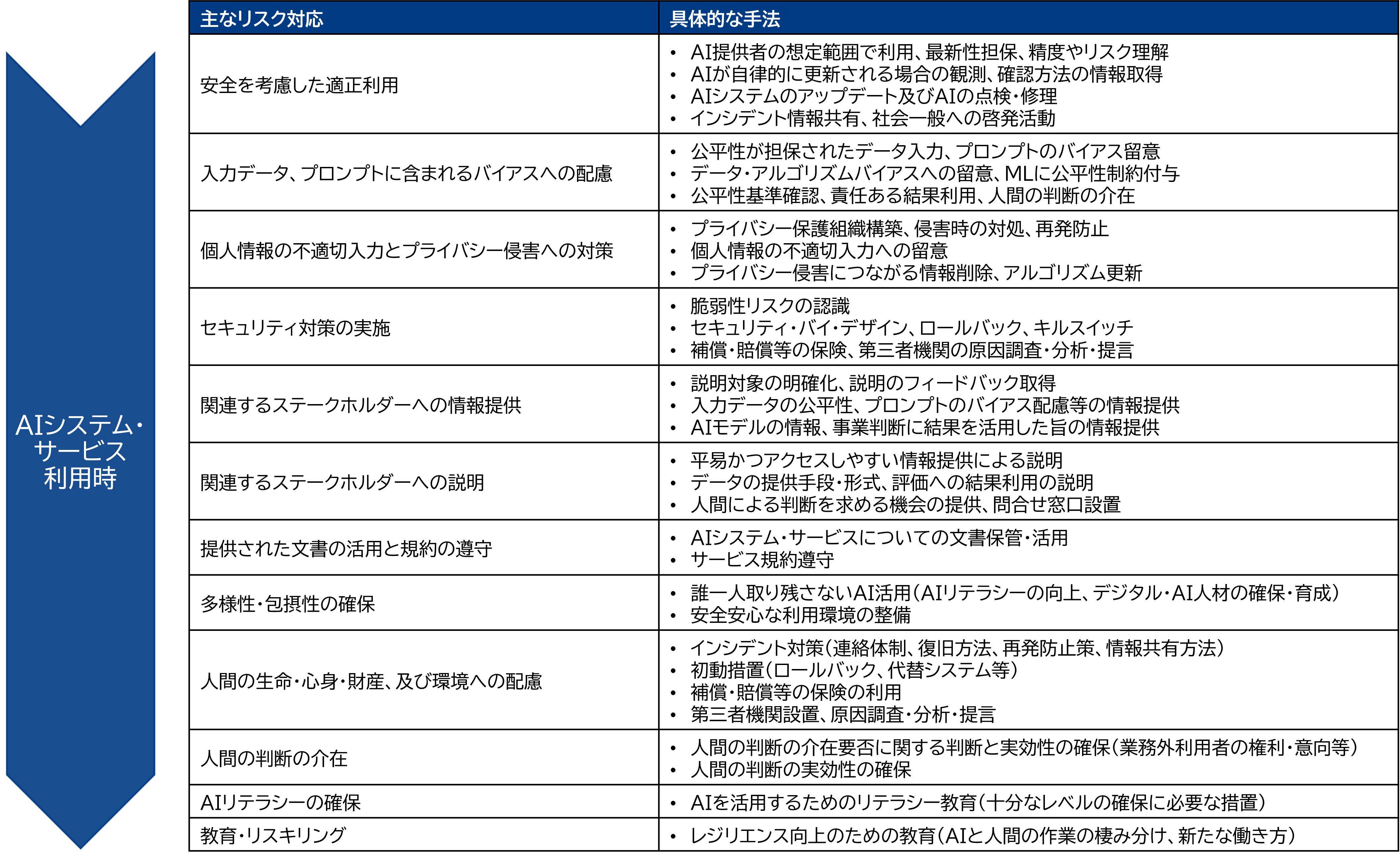

下図に、AI利用者の主な対応内容と具体的な手法をガイドラインから整理したので、参考としてほしい。

出所:AI事業者ガイドライン案より三菱総合研究所作成

出所:AI事業者ガイドライン案より三菱総合研究所作成

手順④ 運用(モニタリング)、評価

ここでは、カスタマイズされたチェックリストの運用、運用状況のモニタリング、モニタリング結果をもととした評価を実施する。

ガイドライン案では、チェックリストの運用時に、「チェックリストを作成する者(当該チェックリストを基に、各自のチェックリストのカスタマイズを行う者)」「チェックを行う者(現場において実際のチェックを行う者)」「責任者(チェック内容に対して責任を負う者)」を特定することとしている。手順①で検討した体制から担当者を選定して実施する。

実際に運用すると、想定していなかった新たなリスクが発生していたり、想定していたが実際には対応不要なリスクがあったりする。対応コストが想定と乖離する可能性もあるため、必要に応じてリスクおよびリスクの優先度を改めて評価し、チェックリストを改訂していく必要がある。

リスク対応に割ける企業のリソースは有限である。対応すべきリスクの優先度は、各リスクが生じうる可能性とリスクの及ぼす影響から定量的・定性的に判断する必要がある。法制度的なレギュレーションリスクだけでなく、社会での評判などレピュテーションリスクも勘案しながら優先度を検討する必要がある。

手順⑤ 体制とコストの再検討(手順①に戻る)

手順④で運用(モニタリング)、評価を実施すると、必要な体制やコストが計画時から変動する場合もある。また、法規制等の社会制度の変更や、リスク対応技術の進歩等によっても、必要な体制やコストは変動する。変動があった場合は、手順①へ戻り、体制やコストを再検討する。

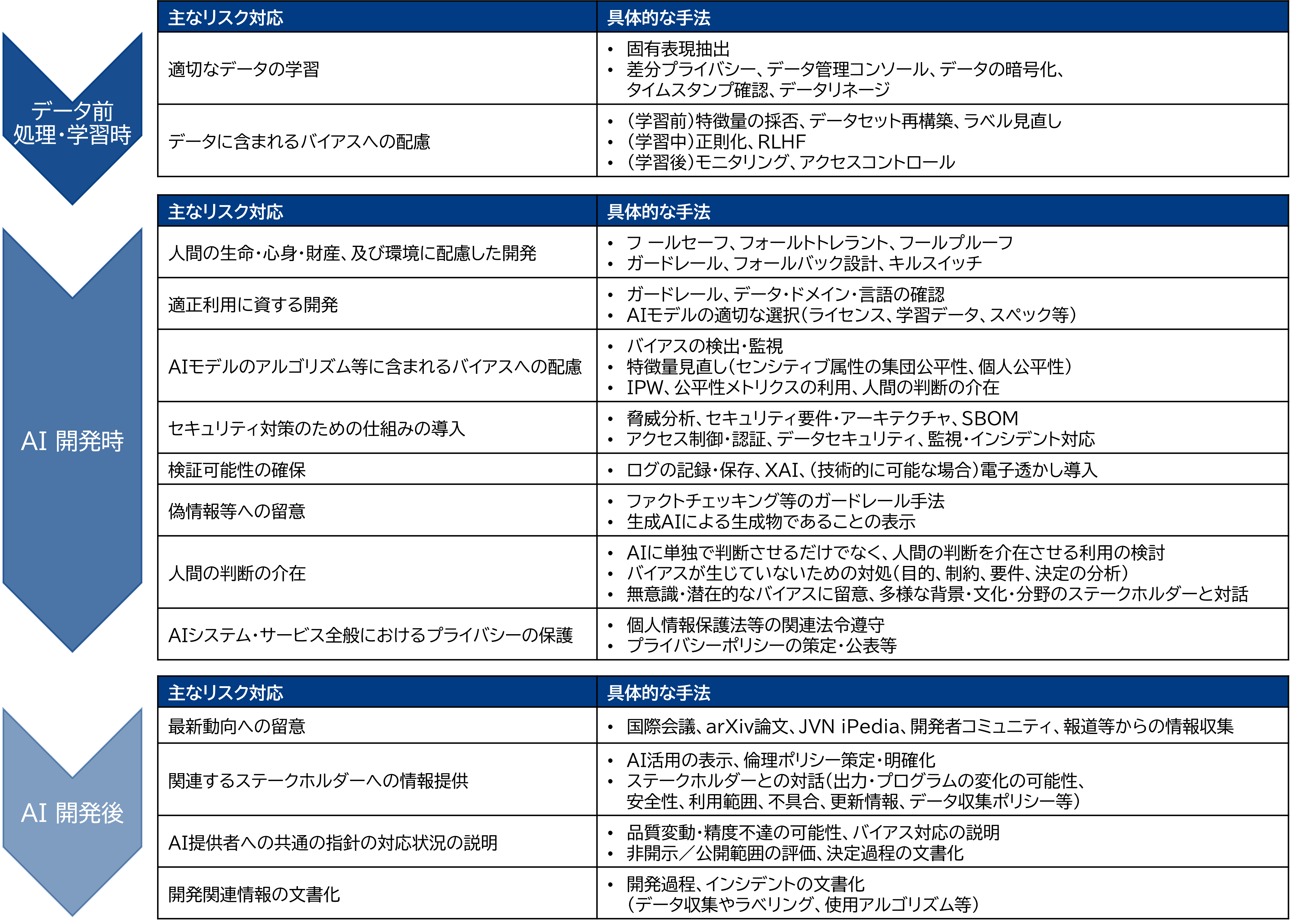

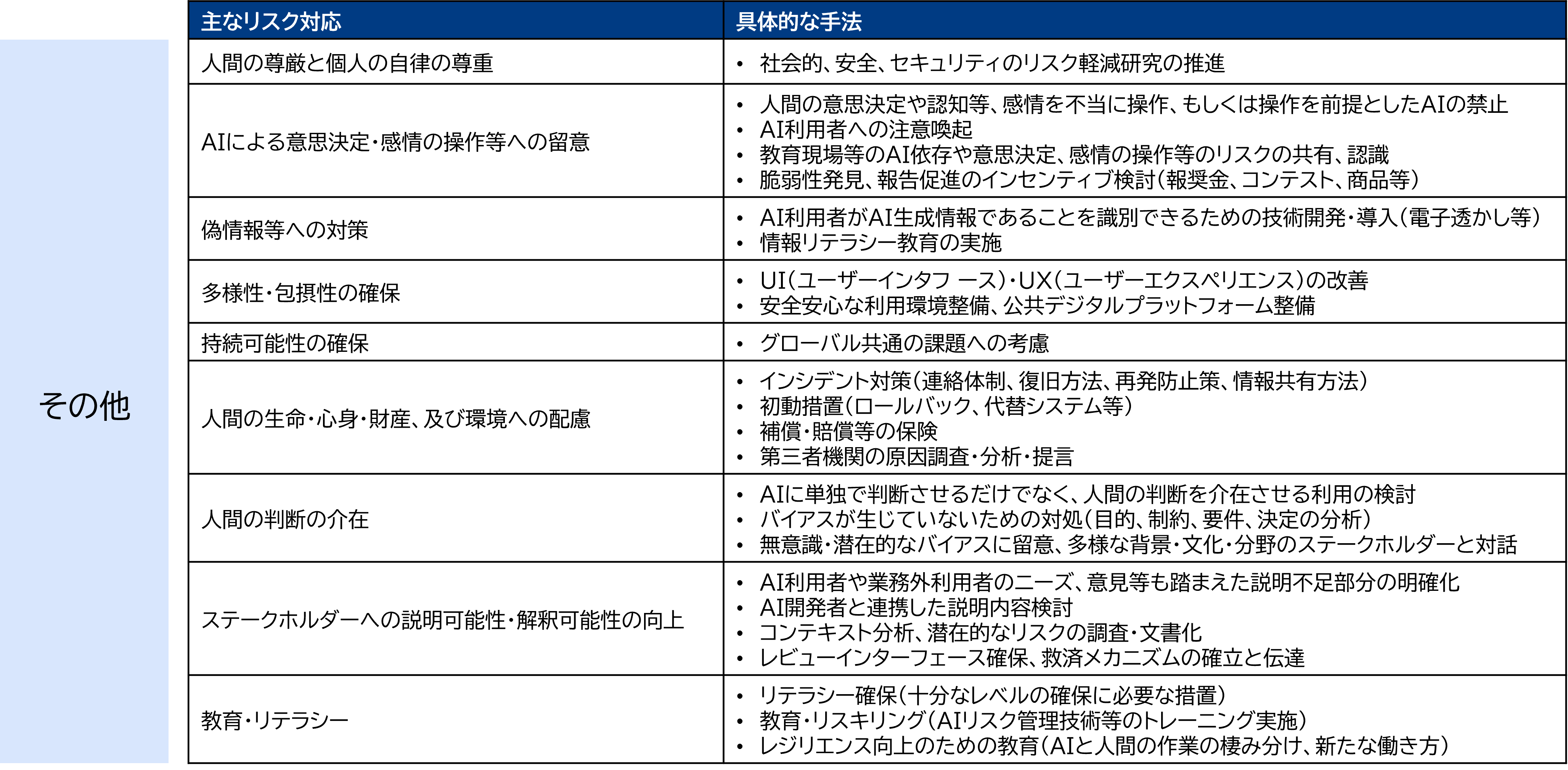

参考:AI開発者、AI提供者の対応内容

ここまで、AI利用者の対応を中心に解説してきた。AI利用者と同様に、AI開発者、AI提供者の対応内容の例をガイドライン案から整理したので、参考としてほしい。

【AI開発者の対応内容】

ガイドライン案では、「データ前処理・学習時」「AI開発時」「AI開発後」の各工程とその他に分けて対応と手法が記述されている。この分類ごとに把握すると理解しやすい。

出所:AI事業者ガイドライン案より三菱総合研究所作成

出所:AI事業者ガイドライン案より三菱総合研究所作成

「データ前処理・学習時」の対応は、設計段階から個人情報・機微情報の扱いや公平性の担保に対応できるよう、いわゆるプライバシー・バイ・デザイン、フェアネス・バイ・デザインの考え方が採り入れられている。ガイドラインでも、開発者が社会に与える影響の大きさや事前の対応策の重要性が述べられており、対応内容に反映されている。

「AI開発時」「AI開発後」の対応は、安全性やセキュリティ確保、透明性・アカウンタビリティのリスク対応が中心だ。AI開発後の対応として最新動向への留意が挙げられているように、新しい技術対策も日々進んでいる。事業者は常に動向把握する必要がある。

「AI開発時」「AI開発後」の対応は、安全性やセキュリティ確保、透明性・アカウンタビリティのリスク対応が中心だ。AI開発後の対応として最新動向への留意が挙げられているように、新しい技術対策も日々進んでいる。事業者は常に動向把握する必要がある。

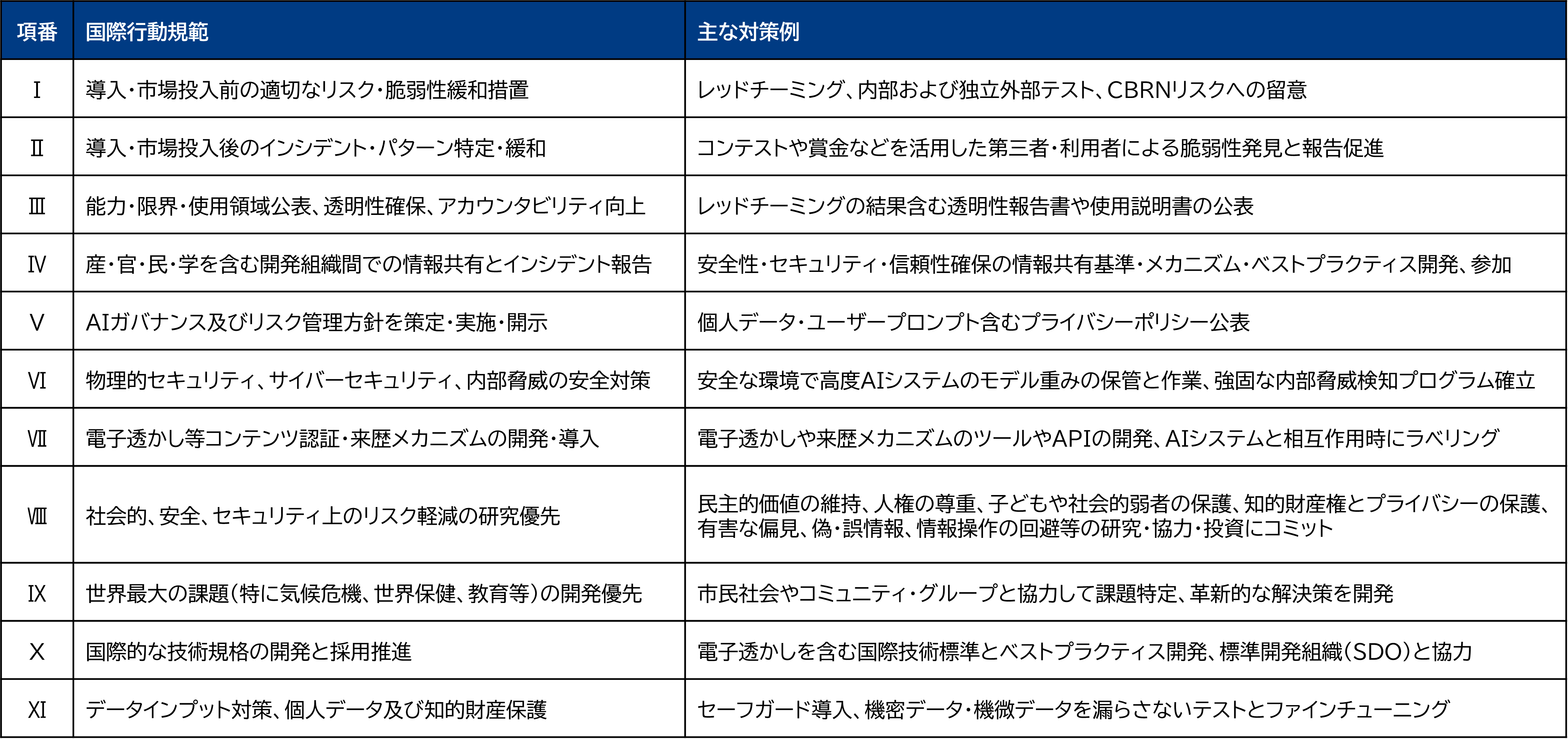

なお、高度なAIシステムを開発するAI開発者は、「高度なAIシステムを開発する組織向けの広島プロセス国際行動規範」も遵守すべきとされている。該当する事業者は留意が必要だ。

出所:「高度なAIシステムを開発する組織向けの広島プロセス国際行動規範(仮訳)」より三菱総合研究所作成

出所:「高度なAIシステムを開発する組織向けの広島プロセス国際行動規範(仮訳)」より三菱総合研究所作成

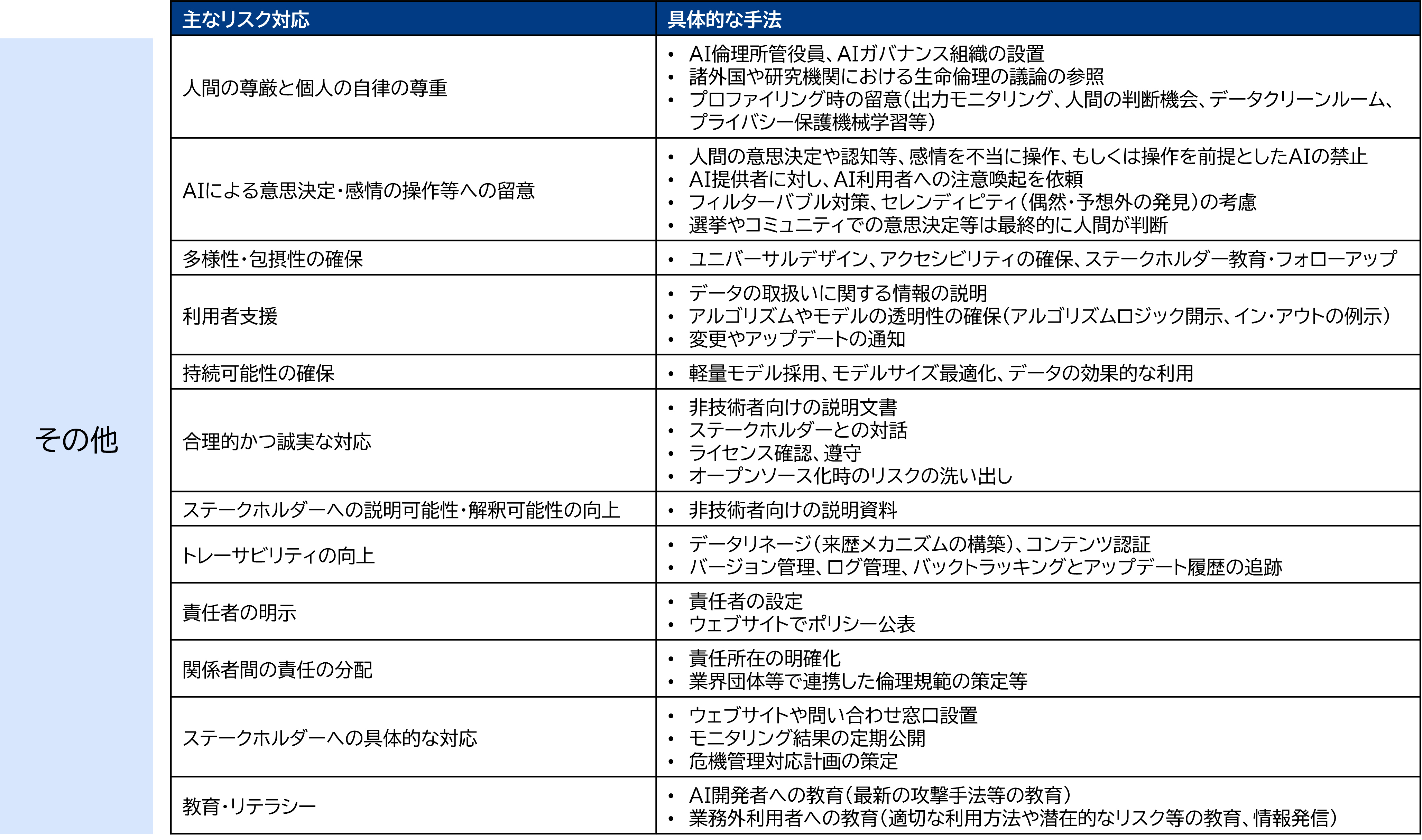

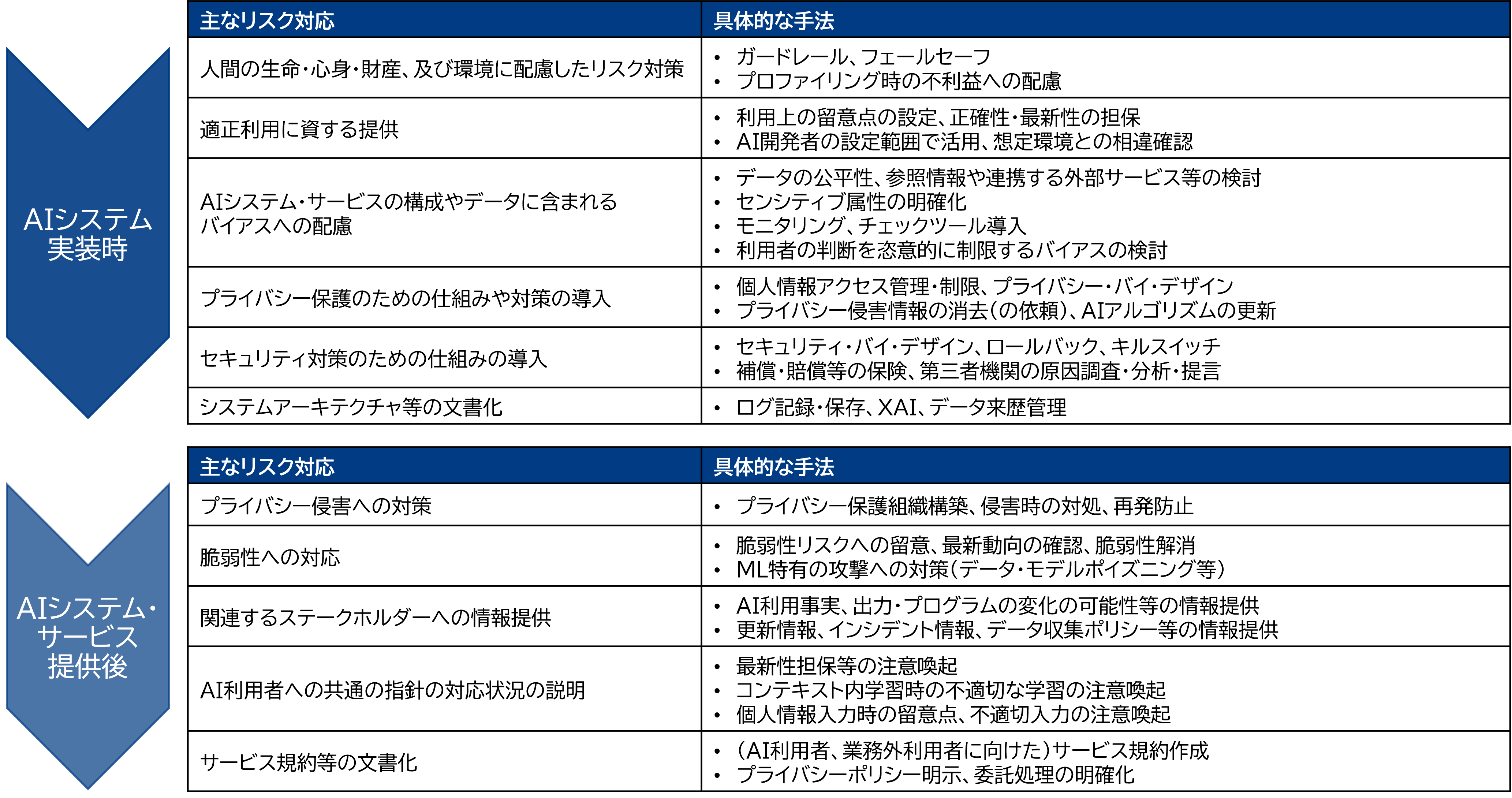

【AI提供者の対応内容】

AI提供者も、AI開発者と同様、ガイドライン案では、「AIシステム実装時」「AIシステム・サービス提供後」の各工程とその他に分けて対応と手法が記述されている。この分類ごとに把握すると理解しやすい。

出所:AI事業者ガイドライン案より三菱総合研究所作成

出所:AI事業者ガイドライン案より三菱総合研究所作成

AI提供者の対応は、AI開発者と類似した内容が多い。

「AIシステム実装時」の対応は、幅広いリスク対応が挙げられている。AI開発者のような技術的な対応は少ないものの、AI利用者あるいは業務外利用者に対して幅広い対応が求められることになる。

「AIシステム実装時」の対応は、幅広いリスク対応が挙げられている。AI開発者のような技術的な対応は少ないものの、AI利用者あるいは業務外利用者に対して幅広い対応が求められることになる。

「AIシステム・サービス提供後」についても同様であるが、利用者に直に接する主体として、最新性担保の注意喚起やインシデント情報提供などステークホルダー間の情報共有に関する対応が多くなっているのが特徴的である。

本コラムおよび第3部のまとめ

本コラムにて、生成AIコラム第3部「生成AIのリスク・懸念と対策」が終了となる。

本コラムでも触れた通り、ガイドラインの目的は、あくまでもAIのリスクを抑えながらイノベーションを促進することだ。安心安全で利用できなければ、イノベーションを生み出すことは難しい。日本のAI産業が、この新しいAI事業者ガイドラインをきっかけに飛躍することを願う。

第3部では、はじめに生成AIによる企業のリスクや社会的懸念、およびその対策を紹介した。また、AI規制とガイドラインの動向など世界のAIガバナンスについて、最後に日本の事業者ガイドライン案について紹介した。生成AIは、正負両面で非常に大きなインパクトのある技術ということがお分かりいただけたのではないだろうか。日進月歩の技術であり、規制やガイドラインも適宜更新していく必要がある。2023年のG7議長国であった日本には、引き続き、世界のAIガバナンス議論で存在感の発揮を期待したい。

当社も引き続き、このような視点を大切に生成AIのリスク・懸念と対策について研究を深める予定だ。最後までお読み頂いた感謝を申し上げて第3部を終える。

本コラムでも触れた通り、ガイドラインの目的は、あくまでもAIのリスクを抑えながらイノベーションを促進することだ。安心安全で利用できなければ、イノベーションを生み出すことは難しい。日本のAI産業が、この新しいAI事業者ガイドラインをきっかけに飛躍することを願う。

第3部では、はじめに生成AIによる企業のリスクや社会的懸念、およびその対策を紹介した。また、AI規制とガイドラインの動向など世界のAIガバナンスについて、最後に日本の事業者ガイドライン案について紹介した。生成AIは、正負両面で非常に大きなインパクトのある技術ということがお分かりいただけたのではないだろうか。日進月歩の技術であり、規制やガイドラインも適宜更新していく必要がある。2023年のG7議長国であった日本には、引き続き、世界のAIガバナンス議論で存在感の発揮を期待したい。

当社も引き続き、このような視点を大切に生成AIのリスク・懸念と対策について研究を深める予定だ。最後までお読み頂いた感謝を申し上げて第3部を終える。

-

AI戦略会議 第7回 資料1-3 AI事業者ガイドライン案 総務省 経済産業省(2024年1月12日閲覧)

https://www8.cao.go.jp/cstp/ai/ai_senryaku/7kai/13gaidorain.pdf - 「環境・リスク分析」「ゴール設定」「システムデザイン(AIマネジメントシステムの構築)」「運用」「評価」「環境・リスクの再分析」の各プロセスについて解説している。

- 本コラムの手順に限定するものではない。各企業で既に確立されている手順や各企業に合った手順があれば、そちらを採用すべきである。

- ガイドライン案では、「具体的な検討にあたっては開発・提供・利用予定のAIのもたらすリスクの程度及び蓋然性や、各主体の資源制約に配慮することが重要である」としている。

- 詳細は第3部第1回コラムを参照

-

以下のようなデータベースが紹介されている。広くリスク情報を収集したい企業や海外事業を予定している企業などは参照したい。

The AI Incident Database(AIID)(Partnership on AI)、AI Incident Tracker(GitHub)、AI Incidents Monitor(AIM)(OECD) -

株式会社三菱総合研究所 ニュースリリース 2023.10.30 WebサーベイAI「ロボリサ」のレポート作成機能が進化 自然な表現でさらに高品質なレポートを自動作成

https://www.mri.co.jp/news/press/20231030.html -

文化庁著作権課「AIと著作権に関する考え方について(素案)」に関する意見募集の実施について(2024年2月1日閲覧)などが参考になる。

https://public-comment.e-gov.go.jp/servlet/Public?CLASSNAME=PCMMSTDETAIL&id=185001345&Mode=0 - 具体的には、「本チェックリストは、あくまで各事業者が取り組むべき事項が何かを検討する際の材料をご提供するものであり、各事業者それぞれの状況に応じ、カスタマイズして必要に応じて活用いただくことを前提としたものです。したがって、必ずしも、全ての事項について、検討が必要となるものではございませんので、活用の要否、各自の事情に応じた修正や取捨選択を検討ください。」としている。

- ここに挙げた事例は仮想的なものであり、自社の事業に応じた例も考えてみてほしい。

- 大規模言語モデルに回答を生成させる際に、外部の知識を検索して回答に反映させる技術。事業者内に蓄積されている情報や、最新の情報などを反映させることが可能。

-

JDLA 生成AIの利用ガイドライン(2024年2月5日閲覧)

https://www.jdla.org/document/#ai-guideline - 対応と手法の詳細はガイドライン案を参照。全ての対応と手法が記載されているものではないことに留意。

- 各主体の規模によって重複する場合もあるとしている。

- 対応と手法の詳細はガイドライン案を参照。全ての対応と手法が記載されているものではないことに留意。

-

具体的には、以下のように述べられている。

「AI開発者は、AIモデルを直接的に設計し変更を加えることができるため、AIシステム・サービス全体においてもAIの出力に与える影響力が高い。また、イノベーションを牽引することが社会から期待され、社会全体に与える影響が非常に大きい。このため、自身の開発するAIが提供・利用された際にどのような影響を与えるか、事前に可能な限り検討し、対応策を講じておくことが重要となる。」 -

外務省 高度なAIシステムを開発する組織向けの広島プロセス国際行動規範(仮訳)(2024年2月2日閲覧)

https://www.mofa.go.jp/mofaj/files/100573472.pdf - 日本は、2024年のOECD閣僚理事会の議長国である。